出典:SIGGRAPH Asia 2018

SIGGRAPH Asiaが東京に来た!

12月4日より東京国際フォーラムにて、最新の技術や製品化や実用化されていない技術を発表する「SIGGRAPH Asia 2018」が開催された。SIGGRAPH Asiaの国内開催は2009年の横浜、2015年の神戸に続き、今回で3回目の開催。これまでSIGGRAPHは定期開催されていても、遠い、行けないという場合がほとんどだった。しかし、今年のSIGGRAPH Asia 2018は都内周辺から参加できる。願ってもいない絶好の機会だ。

SIGGRAPH Asia 2018の見どころは、これまで北米のSIGGRAPHに行かなければ見られなかったセッションがいくつか行われることだ。例えば、北米のSIGGRAPHでしか見られなかった「Real Time Live!」を東京でも開催。来場者のいる前で、リアルタイムCG技術の紹介とデモを行うというイベントで、ライブ感のあふれる人気のアトラクションが東京でも行われる。Real Time Live!は12月7日に行われる予定だ。

4日の初日は受付の待ち時間も話題になった

SIGGRAPH Asia 2018のテーマは「クロスオーバー」で、技術者やメーカーなどが交流する場として、このSIGGRAPH Asiaを使ってほいしという思いが込められている。SIGGRAPHを機会に将来のビジネスチャンスやパートナーシップを探すのには絶好の機会だが、今年のSIGGRAPH Asiaでは人材交流ができるレセプションが設けられていて積極的な交流が行われていた。

5日の夜にはReceptionを開催 出典:SIGGRAPH Asia 2018

開催前の来場者数の⾒込みはSIGGRAPH Asiaの中でも過去最高の10,000⼈を予定しているが、12月4日の初日では参加登録受付で長蛇の列ができたことが話題になった。最終的には、1万人の来場者を超えることは確実なのではないだろうか。

映像関連ブースの展示をチェック

SIGGRAPHといえばカンファレンスだが、展示会場の熱気も凄かった。特に目立っていた出展企業の様子を紹介しよう。

SIGGRAPH Asia 2018の展示会場のコマ図。出展社の数も多い

■撮影前のプレビズやチェックができるViewfindRの技術デモを展示-スタッド

映像制作会社のスタッドブースでは、ハイエンドなリアルタイムバーチャルスタジオと同程度+αの機能を持った撮影前のプレビズやチェックができるシステム「ViewfindR」を展示。ブースに用意されたカメラには15mmの魚眼レンズが取り付けられていて、モニターを覗くと人とCGが魚眼レンズの歪みに合わせてリアルタイム合成できている。ブースは狭いのにきちんと矛盾がない状態で、魚眼レンズの世界にCGを合わせ込んだ世界を実現していた。

ゴーグルの中の世界と物理カメラ、レンズが連動する感じだ

ゴーグルを付けてグリーンバックのスタジオを覗くと視界の中にカメラがあり、パンなどの操作をすると視界の中のモニターもリアルタイムに連動する。つまり、バーチャルスタジオの中に入って撮影が可能になる。

通常のバーチャルスタジオ撮影は、あくまでも監督がマスモニで見ながら外から「ああして」「こうして」みたいな感じで撮影が行われるが、ViewfindRを使えば監督やカメラマンが実際にVRの中に入ってCGの中で一体になりながら、バーチャルの撮影が可能となる。

魚眼レベルのレンズデータを取得し、CGと合わせている

岡田氏によると、ポストプロダクションとして仕事をする上で、合成撮影をする際にCGがどのようになるのかわからない状態のままグリーンバック撮影が進行してしまって散々な思いをした経験が何度もあるという。そういった問題を改善したい思いで、撮影前の試行錯誤を少しでも制作フローに入れられればと思い、このようなシステムを考えたという。

エンジンはUnreal Engineを使っており、バージョン4.2や4.21でAJAやブラックマジックの組み込みに対応したものを活用して動いている。

今回は、技術デモとしての出展であり、今後はソリューションの形にして、映画のプリビズやCMのプリビズで活用できるようにしていきたいとのことだ。

unReal Engineを使用して実現している

■24のカメラを搭載したVRカメラ「JAUNT ONE」を展示-IMAGICA GROUP

8K・360°の撮影が可能なJAUNT ONEの展示が目立っていた。国内でJAUNT ONEを保有しているのはIMAGICAグループのみ。つまり日本に一台しかないカメラだ。

JAUNT ONEの最大の特長は、24個のカメラユニットを搭載しているところだ。例えば、Insta360 Proの場合は横方向にレンズを6個搭載しているが、魚眼レンズのためにステッチングしたときに縦方向のビルや柱が歪んでしまう場合があった。

JAUNT ONEは一個一個が広角レンズで24個ものカメラを搭載しているので縦方向のビルであればまっすぐに映る。撮影は8K3Dで30P、60p、120Pが可能。120Pで撮ったのを30Pにしてスローモーションもできる。

IMAGICAではJaunt ONEを導入し、同システムを利用したVR映像の制作が行われている

また、Insta360 Proは、カメラ1個1個をオペレートすることができないが、JAUNT ONEはカメラの一個一個のシャッターや感度を変えて撮影することができる。

ファンを搭載しておらず、空気冷却で動作できる。日本の夏の野外とかでも動作は問題なく、そのへんのしっかりした設計も特長だという。今後も、JAUNT ONEを使って撮影された360°コンテンツの誕生が楽しみだ。

24台のカメラユニットは個別に設定できる。つまり向きによって最適な露出に合わせて撮影ができるわけだ

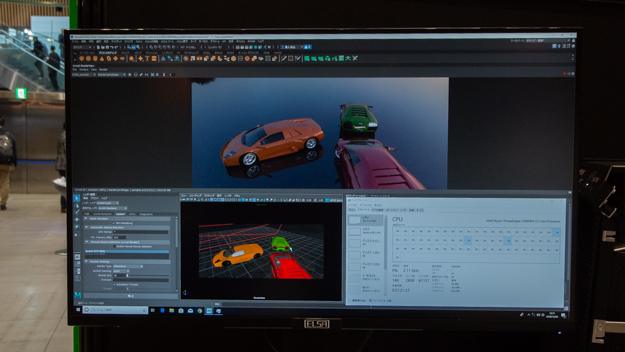

■リアルタイムレイトレーシングを実演-エルザジャパン

「Turing」を搭載したNVIDIA RTX6000上で動作するGPU対応版Arnoldのデモが行われていた。RTXは、今までのCUDA並列処理コアとNVIDIA RTコア、NVIDIA Tensorコアという3つが1つになったアーキテクチャーテクノロジーになっており、このRTコアを使ったレイトレースの速度を体験できるデモとなっていた。

車三台と海の景色のシーンのレイトレースをAMD Ryzen Threadripper 2990WX 32コアプロセッサで計算するのに対して、GPUレンダリングに切り替えた際の計算時間は約10倍の速度を実現できていた。

これまでレンダリングを行なう場合はCPUサーバみたいなものを使って作業をしていたが、これからはクリエイターの横にあるワークステーションを使って作業ができる時代が来そうだ。そうなると、作業のワークフローもだいぶ改善されるだろう。

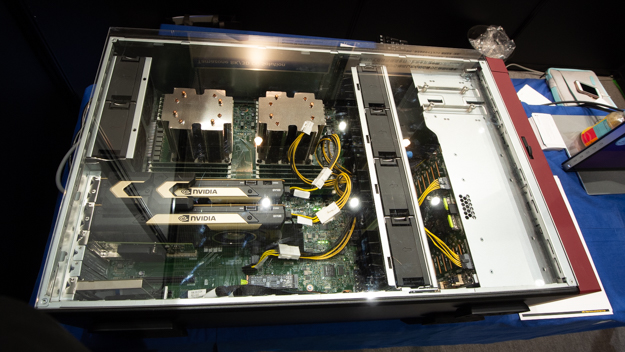

ワークステーションにはQuadroのRTX6000を2枚搭載。NVLINKで2枚のカードをジョイントでリンクしているが計算の処理は1枚

オートデスクのMaya 2018でArnoldレンダラーを使ったテストが行われていた

■8K映像編集にも対応するのワークステーションを展示−アストロデザイン

アストロデザインは独自設計で8K映像などの大容量データを取り扱えるTamazone Workstationを展示。リアルタイム心臓ビューワーと8Kモニターを組み合わせてリアルタイムに8K60Pコンテンツをデモしていた。8Kの解像度で心臓のCGを動かしたり、断面生成もリアルタイムにできていた。

展示のメインであるTamazone Workstationのスペックに驚く。CPUは最大56コアで、メインメモリーは最大768GB。最大64TBの8K映像をリアルタイムでリード、ライトできる内蔵ストレージスピードを実現している。特に、NVMe SSDを16個搭載可能。これには圧倒されるばかりだ。

リアルタイム8Kコンテンツを処理できるワークステーションの展示が行われていた

本体右側の内部にNVMe SSDを16個搭載している最大64TBまで搭載可能

■Thinkbox DeadlineのデモやEC2スポットインスタンス50ドル分無料利用クーポンを配布−AWS Thinkbox

2017年にAWSは、レンダリングの管理システムを持っているThinkbox Deadlineを買収。Thinkboxはいろいろな製品をラインナップしているが、クラウドと連動して動くDeadlineの最新バージョン10を展示していた。

Thinkbox Deadlineの最新バージョンを展示

また、トライアルで使えるAmazon EC2スポットインスタンス50ドル分無料利用クーポンを配布中。気になる方はぜひブースをチェックしてほしい。

来年の春が有効期限の50ドル分無料利用クーポンを配布

■立体の人形をスキャンして3Dモデル化-HUAWEI TECHNOLOGIES JAPAN

HUAWEI Mate 20 Proには、フロントカメラにカラーのカメラと形状を撮れるカメラを搭載。その形状を撮れるカメラを使って小さな物体をスキャンするデモが行われていた。

形状が撮れるカメラはフロントのほうにのみ搭載されているので、フロントカメラを被写体にさまざまな方向から向けてスキャンする。形状の情報がどんどん統合されていって、最終的に1つのモデルが出来上がる。

撮れなかった面を補完する機能を搭載している。スキャン時にプログレスバーを表示して、オブジェクト全体からどれぐらいの割合がスキャンできたかを確認できるようになっていた。

被写体の撮れる色に制限はない。しかし、複雑な形状とかになってくると、うまく形が取れなかったりはするという。試しに持っていたミラーレス一眼カメラをスキャンして頂いたが、うまくスキャンできなかったようだ。

パンダの人形をさまざまな方向からスキャンする

スキャンした人形に骨格の情報を入れて動かすことが可能

ファーウェイはARのエンジンを自社開発している。そちらと作ったモデルを組み合わせて楽しめる

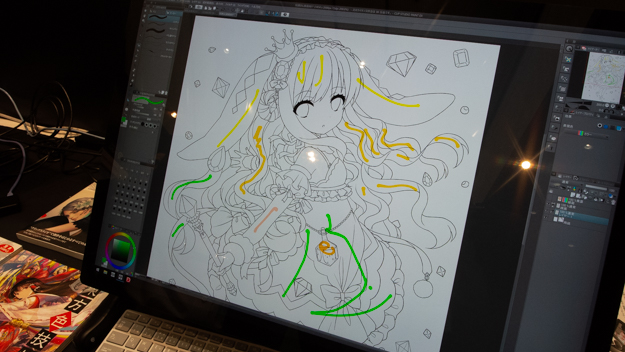

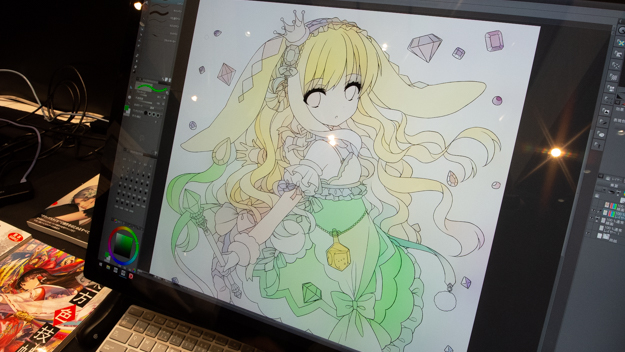

■AIで線画を自動彩色してくれるCLIP STUDIO PAINTの最新版を展示-セルシス

SIGGRAPHは日本の漫画やセルアニメには縁のないイベントというイメージが強いが、イラスト、マンガ制作ソフトアプリでお馴染みのセルシスが出展。同社はSIGGRAPH ASIAに初出展で、CLIP STUDIO PAINTの新機能を紹介していた。

特にアピールしたいのはAIを用いた「線画の自動彩色」機能で、線画の下にラフにヒントとなる色を乗せるだけで彩色をしてくれる機能。ヒントの色を元に「だいたいここまで塗るんだよね」とサーバ側で認識をして自動的に着色をしてくれるという。結果はご覧の通り。「ここまでソフトまかせで着色しちゃっていいの?」と思うぐらい、自動的に着色してくれる。もはやツールの領域ではなく、アシスタントと呼びたくなるぐらいの頼もしい機能だ。

線画とその下のレイヤーに着色のヒントの色を加えた状態

ヒントを元に自動的に着色してくれる。ここまでやってれるのか?という感じの機能だ

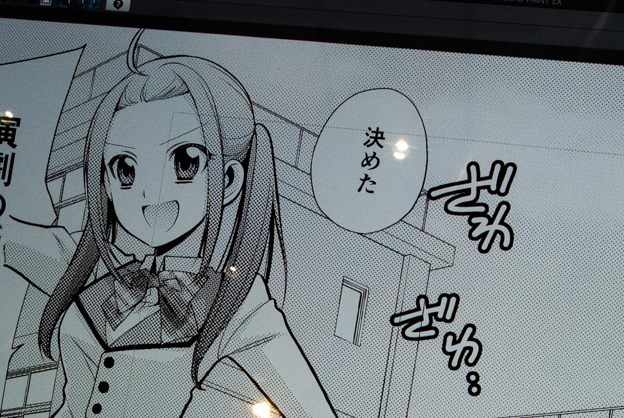

もう1つ大々的に紹介していたのが「トーン除去」機能。漫画にトーンが入っているがレイヤーは統合されてしまって編集ができないことがある。また、もともとモノクロで連載をしていたものをカラーに変えて再販売したいといった場合は、トーンを一個一個はずしてそこに着色をしていくという地道な作業が必要になる。

トーン除去は、選択範囲を設定した範囲のトーンだけを消去する。すでに出版されている漫画から特大サイズのポスターを作る際にも役立つだろうとのことだ。

トーンを削除する前の状態

選択範囲からトーンのみを除去してくれる。これまでこの作業を手でやるのは困難だった

バーチャル関連の展示をチェック

■スマートフォンのカメラで表情のトラッキングができる最新版を公開-BinaryVR

米国、カリフォルニアのソフトウェア会社BinaryVRは、リアルタイムのフェイシャルトラッキングソリューション「HyprFace」を展示。最新バージョンではスマートフォンの内蔵RGBカメラで表情のトラッキングや視線追跡、舌の追跡などが可能。3Dキャラクターに反映させることができる。

スマートフォンの内蔵カメラで捉えた顔を即トラッキング

トラッキングした顔をキャラクターに置き換えることが可能

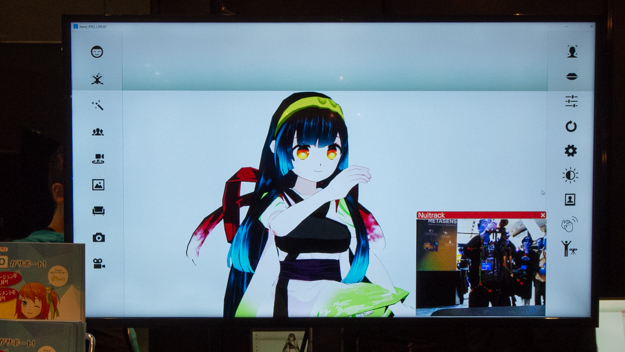

■キャラクターが自由自在に動く動画が簡単に作れる-プラスプラス

PLUSPLUSは、バーチャルユーチューバー向けPC版アプリ「3tene」と「3tenePro」を展示。3teneはバーチャルYouTuberを簡単に手軽に扱えることを目的として作られたアプリ。ノートパソコンに搭載されているカメラでフェイストラッキングをしたり、キーボードに動きのショートカットが可能。口の動きもリップシンクも同期できるので、簡易的な配信であれば十分であろう。

骨格を検出。キャラもトラッキングしたカメラを手にもつ同じポーズになった

こちらは3teneProによるLeapMotionのデモも行われていた。手や指の動きをトラッキングできる。別のカメラで顔認識も可能。手の動きと顔の動きを合わせて表現することができる。

LeapMotionを使えば手の演技が可能になる

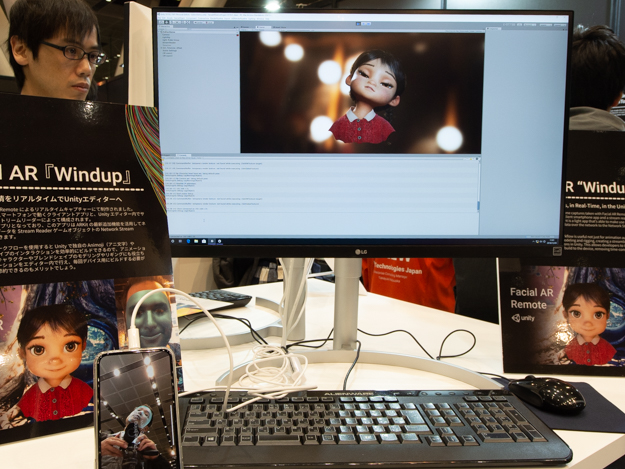

■Unity上でのフェイストラッキング-ユニティ・テクノロジ ーズ・ジャパン

ユニティブースでは、Unity上でのフェイストラッキングする「Facial AR Remote」をデモ。iPhoneのTrueDepthカメラを使ってライブモーションキャプチャのパフォーマンスをキャプチャできるというもの。非常に快適に動いていた。

右下のiPhone Xのカメラを見てほしい。TrueDepthカメラを使って顔のモーションをキャプチャできる「Facial AR Remote」

Unityブースでは定期的に軽食が用意されていた

■カスタムVRシステムを多様なデバイスと組み合わせて展示-フォーラムエイト

フォーラムエイトは、SIGGRAPH Asia 2018東京に独占プラチナスポンサーとして出展。 3DVR技術を展示していた。

フォーラムエイトのソリューションというと、どちらかといえば土木系で大規模なモデリングが可能なのを特長としている。例えば、北海道全体の地形を読み込んで、北海道全体をVRで楽しめるようなプロジェクトが行われているという。

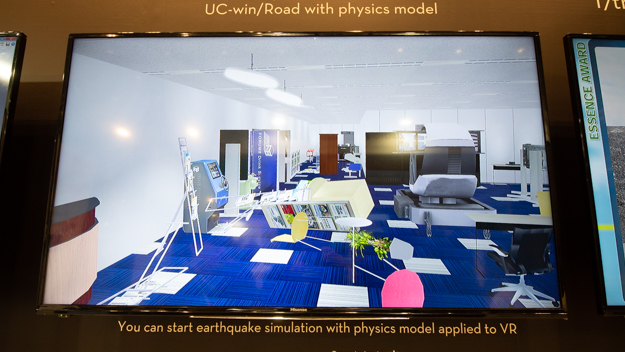

また、気象庁で公開している地震の波形を入力して震災が起きたら建物の中はどのような状態になるのか?シミュレーションをしたり、ソリューションをカスタマイズして運転のシミュレーションも可能といったところを展示していた。

ユーザーの要望によってぜんぜん違うソフトにできる。例えば、カスタマイズによってドライブシミュレーションを実現

地震が起きる前の様子

地震が起きた後のシミュレーション結果