グラフィックス、VFX、CGを実写と合成可能な話題のツール

最近のVFX業界では、バーチャルプロダクションでありながらCGが圧倒的にリアルなZero Densityの拡張現実プラットフォーム「Reality」が話題だ。その実力は、Broadcast Tech Awards 2019やIBC 2017 The Innovation Award、The 39th Sports Emmy Awardなど、権威あるアワードの受賞歴からもうかがえる。Zero Densityは2007年設立のメーカーにも関わらず、今やVFX業界の常識を覆すゲームチェンジャーであるといえるだろう。

国内でも話題になりつつあるZero DensityのRealityを紹介するワークショップが2月26日~27日の2日間、東京・大田区のアークベルで開催された。会場の様子を紹介しよう。

ゲーム業界を支配するUnreal Engineを放送業界のバーチャルプロダクションに活用

まずは会場となったアークベルから紹介する。アークベルは、スタジオの壁面3面をデジタルグリーンに塗装したバーチャルスタジオを常設しており、幕を垂らした簡易的スタイルではなく、塗装によるクロマキー専用スタジオを実現。この規模のバーチャルスタジオは都内でも希少といえる。

アークベルのグリーンバック常設スタジオ

ワークショップ会場では、AカメにAngenieuxレンズ搭載のALEXAが使われ、そのハンドルにstYpe社の超精密光学式カメラトラッキングシステム「RedSpy」を搭載。これにより、カメラの位置情報やレンズデータをリアルタイムに収集し伝送することで、CGレンダリングエンジンとの連動を可能にしている。

Bカメはパナソニックの4Kインテグレーテッドカメラ「AW-UE150」。カメラのトラッキング情報伝達用として広く採用されているプロトコル「FreeD」の信号に対応する。

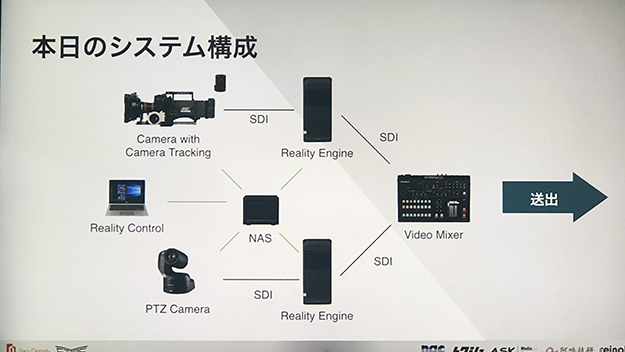

ALEXAにカメラトラッキングシステムの「RedSpy」を搭載

CGのレンダラーは、Reality Engine。ワークステーションはHP Z4 G4 Workstation。GPUはQuadro RTX 6000を搭載。HD-SDIの入出力には、AJAのCorvid 44 12G。1カメにつき1レンダリングエンジンが必要で、今回は2カメなので2つのワークステーションを導入している。その中間にはNASがあり、ここに共通のコンテンツが入っている。その共通のコンテンツをAカメの位置からの視点と、Bカメの位置からの視点それぞれでレンダリングをしている。

Zero Densityの国内での取り扱いはアライアンスとして各企業が携わっており、輸入はアスク、販売はナックイメージテクノロジー、技術的サポートはリーンフェイズ、システム導入は阿吽技研、レンタルと制作は特殊映材社が行っている。

撮影現場のスペースに設置されたRealityのソリューション群

2台のカメラと2台のワークステーションを使ったシステム構成

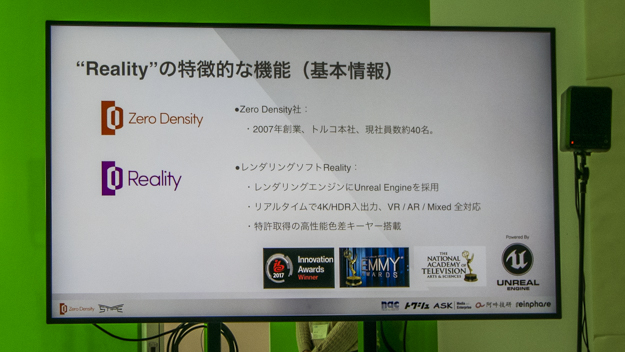

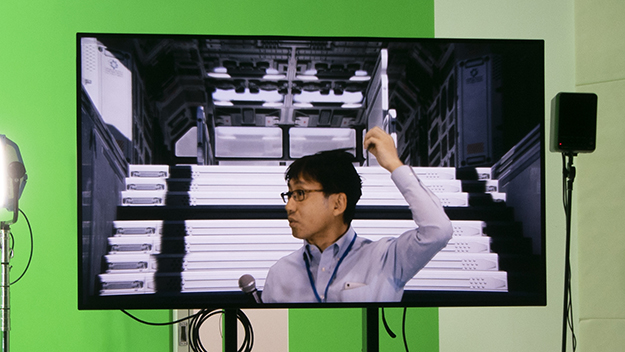

ワークショップでは、Zero Densityの基本情報が紹介された。こちらもレポートしていこう。Zero Density社は2007年創業のトルコに本社を置く会社で、従業員数は約40名。年内には、1.5倍の60名まで拡張を予定している急成長中の会社だという。

Zero Densityが開発しているリアルタイムレンダリングソフトの製品名が「Reality」で、レンダリングエンジンはリアルタイムにフォトリアルなレンダリングが可能なUnreal Engineを使用している。4K HDRの入出力に対応しており、VR、AR、その両方を合わせたMRでの世界観の表現を特長としている。

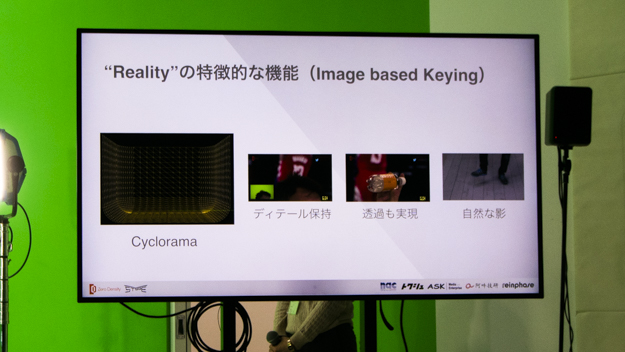

Realityの特長は、ソフトウェア上で色差ベースのキーイングを行うところだ。クロマキーベースのキーヤーは1つのRGB値を選択し、その選択された色を使用してキー信号を作成する。例えば、グリーンバックだったら緑色の部分を抜いて合成をするが、薄いグリーンや濃いグリーンを含めて抜くため、足元の薄い影などは消えてしまう。

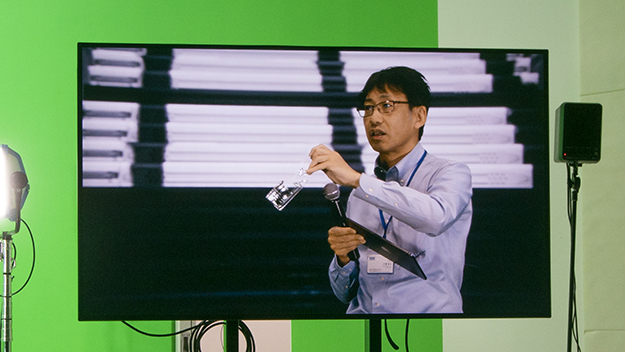

しかし、Realityは、あらかじめ設定されたテクスチャーとビデオ入力を1ピクセル単位で比較する色差ベースのキーヤーを搭載している。そのため、微妙な影を残したり、髪の毛のような繊細な合成もリアルタイムに行うことができる。

Realityの特長はUnreal Engineを使った独自のキーイングテクノロジーを実現しているところだ

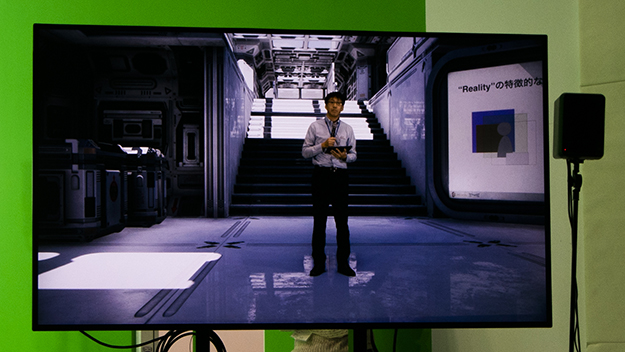

Zero DensityのRealityを紹介するナックイメージテクノロジーの川嶋尚士氏。物理セットと見分けがつかないぐらい仮想セットのCGがきれいだ

例えば、会場のデモを観てみると、床に微妙な影が発生している。これらの影は、Cyclorama(サイクロラマ )と呼ばれる機能によって3次元的にグリーンバックの形状を定義し、実際のカメラ入力からの映像をテクスチャとして貼り付けていることによって可能となるものだ。

Realityはこれまでのクロマキーヤーで実現しにくかったディテール、透過、影の表現を得意とする

足元に注目。微妙な影が再現されている

Cyclorama(写真内の赤い線)と呼ばれる3Dメッシュを設定して、グリーンバックの形状や色を認識させる

気になる抜け具合だが、髪のような細部のキーイングも得意とする

水の入ったペットボトルのような透明なオブジェクトも違和感なく抜くことができる

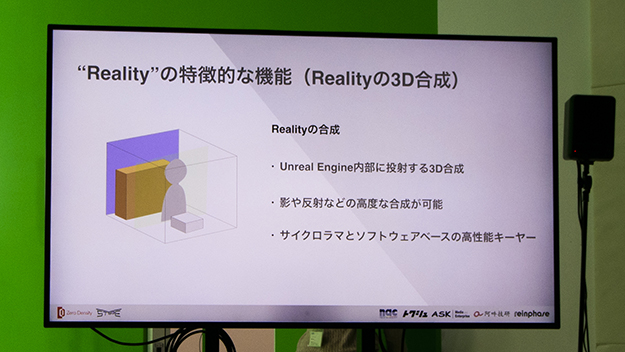

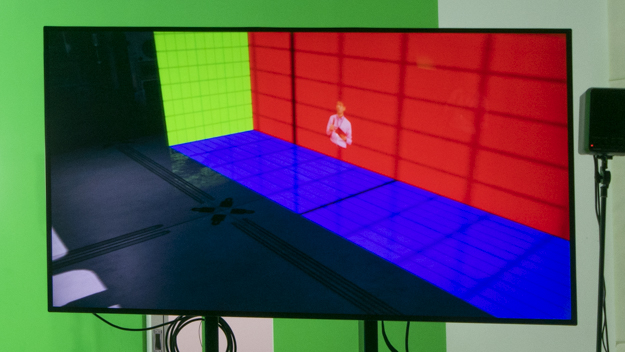

また、Realityは“Projection Cube”という機能によって、カメラで撮影した実写映像とUnrealの3次元空間(バーチャルセット)の配置を定義することができる。Unrealの空間内に配置されるProjection Cubeは6面体のキューブであり、そのキューブの壁面に実際のカメラで撮影した映像をプロジェクターのように照射して位置付けする仕組みだ。

実写映像の前にCGの物体を配置すれば、CGの後ろに実写が立っているように見える、前景・後景も調整できる方式だ。

Projection Cubeと呼ばれる概念で、実写映像は板のような書き割りイメージでCGの3次元内にある

2020年2月28日にはReality 2.9をリリース。Unreal Engine 4.23へのサポートが加わり、4K HDR/HLGに対応するなど、さらに機能がアップデートされた。

Realityはイベントや生放送のライブ撮影だけではない。ドラマでの合成手法を対談形式で紹介

今回のワークショップの目玉は、リーンフェイズの片田江順氏と特殊映材社の伊藤俊介氏による運用実例の対談だ。Realityは、バーチャルスタジオの生中継だけではなく、コマーシャルから映画まで幅広い活用も可能と言われている。

実は今回のワークショップの会場となったスタジオのアークベルでは、先日までRealityを使ったドラマの撮影が行われており、今回のワークショップではそのドラマ撮影で使った運用ワークフローや、実際に使用した感想などが対談形式で公開された。その対談内容を紹介しよう。

対談を行ったリーンフェイズの片田江氏(左)と特殊映材社の伊藤氏(右)

――片田江氏:実際にWeb配信用ドラマのVFX撮影で、グリーンスタジオを使ってリアルタイムに合成が行われたとのことですが、今回のドラマ撮影でRealityのようなリアルタイム合成のシステムを使ってみようと思われた経緯を教えてください。

伊藤氏:リアルタイム合成の技術自体は世界でもはじまったばかりです。InterBEEで私がZero Densityのデモを担当していたときも、「いったいどうやって使うんだ」とか「どういう企画に使うんだ」とよく聞かれました。私たちも「Realityはこういうことに使える」と技術を見せて概要をお伝えするだけでしたが、「こうやって使ったよ」という具体的な実例を見せずには、技術の導入まで進められないと感じてました。

私の本業は撮影監督なのですが、去年1年間、Realityを勉強し、思ったのがドラマ撮影に最適なのではないか?ということでした。そもそもドラマは、ポストプロダクションのワークフローがあるので、リアルタイムでコンポジットする必要はありません。しかし、昨今日本は制作費の予算が少ないという事情があります。そこで、現場でできるだけコンポジットを行おうとプロデューサーに提案をしたら、「それは予算を抑えられそうだね」と反応を頂き導入しました。

――片田江氏:実際に制作費は抑えられましたか?

伊藤氏:安くはなっていると思います。20日間に渡ってドラマ撮影をして、デイリーで約100カットのテレビドラマを撮ってきました。そのあと、バーチャル部分が約4日間です。当初、バーチャル部門が1日20カットぐらいで許してくれるのかと思いましたが、実際にはドラマと同じ1日100カットをバーチャル撮影しました。これは凄い量です。

――片田江氏:それは大変な量でしたね。やっぱりリアルタイムで結果がレビューできるからこそ、1日100カットをバーチャルで撮ることができたのでしょうか?

伊藤氏:そうですね。ただ、今回はトライ的な部分もあり、400カットすべてがリアルタイムの撮って出しでは成立しないと思っていました。というのも、実際に使うとうまくいかないところもあったからです。

ただ、400カットを成立させなくても、今までのドラマの案件は400カットをまるまるポストプロダクションで処理しなければいけませんでしたが、100カットでも現場で成立しているのだったらそれはかなり有意義なことだと思います。あるいは、これまでVFXに回るところをスタジオで処理できるようだったら、それは作業の分担ができているということに意味はあると考えています。

――片田江氏:私は今日のワークショップでバーチャルに映ることを前提に気を使って白い服を避けて着てきました。そういった衣装面などで、合成に苦労されたところはありますか?

伊藤氏:今回撮影したドラマの主人公は白髪で、光沢のある白着物で登場するために苦労しました。

また、ゲーマーのコスプレーヤーが多数出演する内容で、細い刀や光沢のある剣、シルバーの甲冑などキラキラしたアイテムが多数登場します。特に、光沢のある着物の下に透過性のあるレースみたいな「全部やめてくれ」という素材を使っている登場人物もいました(笑)。

あと、今回の作品でキーになったのは、ライトの性質と特性ですね。やはり良いライトを使えばきちんと抜けます。質の悪いライトは、キーイングをかけても上手く抜けません。また、それを突き詰めると、ほかのところが破綻するということがありました。

――片田江氏:通常のグリーンバック撮影では、背景がグリーンで映っているために役者さんたちもどういうシーンを撮っているのか理解しづらいです。しかし、Realityは、リアルタイムに役者さんに返しモニターがあります。そうするとことで、役者さんのモチベーション向上や演技にいい影響のきっかけになったりすることはありましたか?

伊藤氏:自分たちがどこの空間で演技をしているかリアルタイムで確認できるのは、モチベーションの向上に大きく影響すると思いました。また、監督の言っている演出の理解が深まるのにも意味がありました。

――片田江氏:Realityを現場で使って監督の反応はいかがでしたか?

伊藤氏:監督との打ち合わせで最初の段階では、「できる範囲内でいいよ」という話でした。しかし、後半になって何でもできることがわかると、何に関しても言ってくる(笑)。こちらは「そんなことまで言わないで」という感じで対応に追われました。

――片田江氏:運用面で注意したいことはありますか?

伊藤氏:光量は圧倒的に必要です。少なくとも下からのライトの光量が、グリーンを照らしているスカイのライト光量を超えないと、人物に反射しているグリーンを飛ばすことができないからです。そして、クリアなライトが必要ですね。私のお勧めはARRIのSkyPanelです。

また、今回のスタジオ自体がグリーンの幕を垂らしただけの簡易的なスタイルではなく、ちゃんとグリーンに塗ったことも大きく影響していると思います。Realityに関してはCycloramaにテクスチャとしてグリーンをキャプチャしている関係上、幕を使った簡易スタイルだと幕が揺れた瞬間にノイズが発生します。そう言った意味で、Realityを使う上で背景がデジタルグリーンに塗装されている意味は凄まじく大きかったです。全体のワークフローが楽になりますし、スペースも単純に塗ってあったほうが広く使える意味もあるでしょう。

――片田江氏:アークベルは長期間、スタジオをグリーンバックののままにされるとのことです。

伊藤氏:凄いありがたいですね。私達は、機材を搬入して配線をするのに、ものすごい時間がかかります。また、キャリブレーションをしなければいけない時間もあります。Realityが常設できるならば、レンタル期間の日数は少なくても2、3日短縮されるわけです。金額にすると、何十万円下手すれば何百万円をコストカットできることになります。

このRealityを国内で使いたいという場合は、まずここから皆様が案件をトライアルしていただくというのは、大変いいんじゃないかなと思います。

今回使用されたアークベルのスタジオは、今年の2月よりクロマキー撮影スタジオとしてレンタルサービスを開始している。ドラマ撮影だけではなく、イベント・ライブ配信など様々な映像コンテンツ制作に最新のバーチャル技術を使ってみてはどうだろうか。

![富士フイルム「GFX ETERNA 55」展示レポート。発売を迎えたフラッグシップ・シネマカメラの全貌[CP+2026展示レポート]](https://jp.pronews.com/wp-content/uploads/2026/02/9a6242f95b3e1f0ddf61608dcb8310b4-560x410.jpg?crop=1)

![キヤノン、アナログコンセプトカメラを展示。効率を脱ぎ捨て、あえて「手間」を撮る[CP+2026展示レポート]](https://jp.pronews.com/wp-content/uploads/2026/02/b7dc1ea89bd66596cf7e0e563eeaac5f-560x410.jpg?crop=1)

![国産レンズメーカーの意地と戦略。台頭する海外勢にどう立ち向かうのか? Vol.03 [CP+2026特別レポート]](https://jp.pronews.com/wp-content/uploads/2026/02/ed2a82fc008f3ac454eef2e5451913b4-560x410.jpg?crop=1)