txt:江口靖二 構成:編集部

AI技術を放送業務で実装すること。何のためにAIを利用するのか?

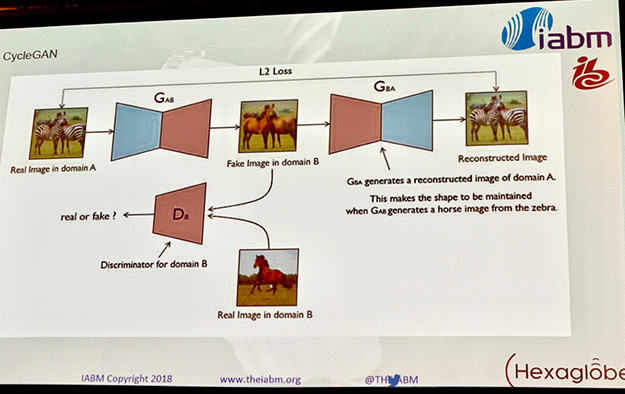

2つのデータソース間の変換を学習するcycleGAN(HEXAGLOBE)

IBC2018ではAI、ディープラーニング、マシンラーニング関連のセッションだけで、なんと18本も設定された。これは4KやIP化に関するものと比較しても圧倒的に多い。その多くはヨーロッパを中心に世界規模で展開する業界団体、IABM(The International Trade Association for broadcast & media technology)が主催する、同時開催イベントのFuture Trend Theaterで行われた。いい悪いはともかく、IBCとNABを比較すると、IBCの方が明らかに「先の話題」が多い傾向は変わっていない。

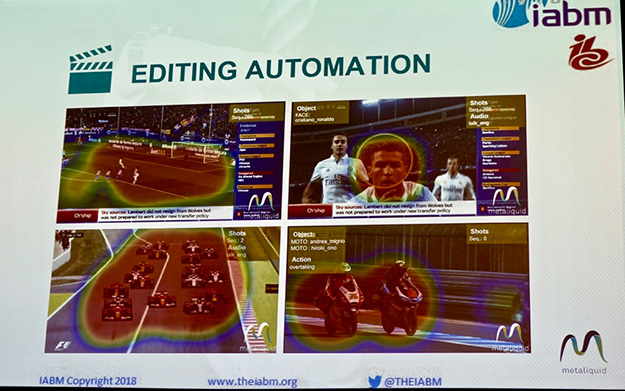

自動編集の考え方(metaliquid)

こうしたAI系のセッションでは、AI技術そのものに関するものとしてのディープラーニングやマシンラーニングに関するものと、実務上の応用やユースケースに関するものに分けられる。

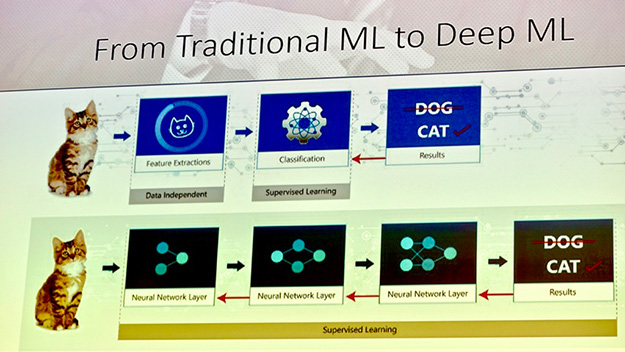

ニューラルネットワークを利用するディープラーニング(interra systems)

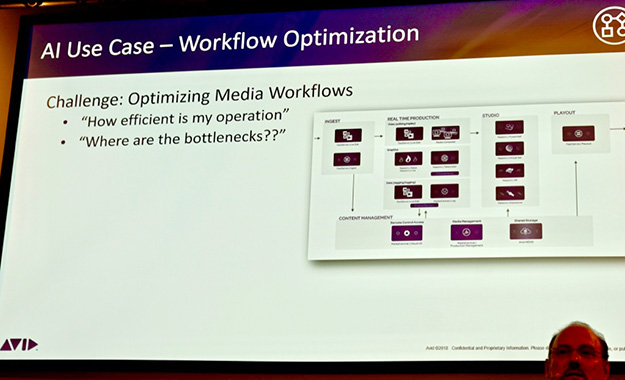

映像業務のワークフローにおけるAI(AVID)

映像関連のAI技術

■画像認識

顔認識

物体認識

オブジェクトトラッキング■音声認識

音声⇔テキスト変換

言語解析

自動翻訳

音声フィルタリングやマスキング■データ解析

視聴率、視聴履歴

SNS情報

業務フロー

などが基礎技術である。他のIoT関連とは異なり、新たにセンサーなどでセンシングするようなことはあまりなく、動画と音声のファイルを解析することと、行動を解析することである。これらの技術によって収集されたデータは、メタデータ、ビッグデータの生成のために利用され、さらにこれらをAIで解析することでビジネスやサービスに利用する。

具体的にテレビ局での様々な業務に置き換えてみよう。

編成

主に視聴に関する実績データからの解析や予測を行うことで

- 自動編成

- マルチチャネル(配信先や配信形態の最適化)

- マルチデバイス(テレビやスマホなどの端末ごとの最適化)

制作

- シナリオ、原稿の自動生成

- ビデオ編集の自動化(言語解析と画像認識を組み合わせる)

- カメラワークやスイッチングの自動化(言語解析と画像認識を組み合わせる)

- AIアナウンサー(すでに実用化されている)

営業

- 広告差し替え(視聴実績や属性に基づいた最適化)

- 編成基軸の枠売りから、コンテンツ基軸の多媒体に対するセールスへ

技術

- コンテンツ監視(暴力、ドラッグ、性的表現などの不適切な表現の抽出)

- 信号監視

視聴者

- 高度なレコメンド

- 高度なコンテンツ検索

例えば大ヒット番組「ビッグ・ブラザー」の制作会社であり、世界中に同番組をフォーマット提供しているオランダのエンデモルが行ったキーノートでは、彼らはAI技術者を多数雇用してコンテンツ内のディスクリプションをタイムコードに合わせて作成し、マイクロソフトと共同で多国語版を完全自動生成する試みを行っているという。

技術的には、例えばリアルタイムの吹き替え技術がほぼ確立されつつある。はじめに吹き替え音声を制作し、続いて吹き替えの声のタイミングに合わせて、オリジナル動画の口元や身振りをシンクロさせてCG生成するという一連の作業をリアルタイムで実現できるレベルになっている。これまで人間が音声に基づいてCGを製作してきた方法よりも、はるかに少ないコストでコンテンツを制作することが可能となる。

これらは今後、翻訳と自動音声合成が自動化される技術が実用化されると、これらを組み合わせて世界中の人気番組を、日本の人気タレントに置き換えて放送する、というようなことも夢物語ではまったくない。

ライブスタジオでの自動スイッチングとカメラワークのデモ

こうしたAIを放送業務に実装する例の一つとして、Mobile Viewpointは、End to end AI powered live productionをコンセプトに、音声信号(マイクレベルなど)、ビデオ画像、オートキューやスクリプトのような他のソースを分析して、どのカメラを切り替えて制御するのかを識別するAIエンジンを使用して、複数のリモートカメラのスイッチングやカメラワークを自動化するデモを行った。

こうしたスタジオの自動運行自体は、ご承知の通り30年前からすでに実用化されているが、それらは予め設定されたことしかできなかった。AIを利用すればこういった事前の設定は一切不要で、進行内容に合わせた自然で効果的な運行が実現できる。

クラウド時代に日本の放送局はどう向き合うのか?

日本ではほとんど知名度がないVO社は非常に先進的なコンセプトで放送ビジネスを俯瞰している会社の一つである

Viaccess-Orcaは、フランスの通信キャリアであるOrange(旧フランステレコム)の子会社であるが、SaaS(Software as Service)ならぬ、TVaaS(TV as a Service)を提案している。このところIoTやAI、そしてこうした映像関連においても、French Tech企業の躍進には目を見張る物があるが、Viaccess-Orcaもその一つに位置づけられるだろう。

これを実現するためのシステムは、当然ながらすべてクラウドベースのものになる。こういう先進的な考え方に対しては、「放送局たるものは○○でなければならない」という反論が日本ではすぐに聞こえて来そうである。大事なことは、何のためにAIを利用するのかということである。それは決して単なるコストダウンではなく、人間が行うべきことにリソースを集中するためである。

これは放送や映像業界に限ったことではなく、ごくごく当たり前のことである。放送事業者とコンテンツ所有者は、消費者のオンラインコンテンツに対する消費者の要求を満たすためには、コンテンツを制作し提供する新しい方法に適応する必要があるということで、それには想像以上にAIが使えるのである。

日本では、特に現場からの抵抗は相当なものがあるだろうが、マネージメント層がビジョンを持って仕切るべきことであると考える。

txt:江口靖二 構成:編集部