txt:安藤幸央 構成:編集部

4K、8Kその先の映像技術

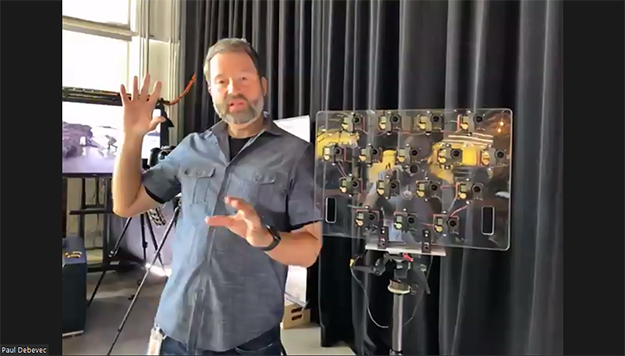

最新のライトフィールドビデオに至るまでの実験機器

今回、オンラインで開催されたSIGGRPAH 2020の最注目株は、視聴者が視野角や映像の遠近、視点などを撮影後に変えることができる、ライトフィールドビデオの技術だ。ライトフィールドカメラの技術は数年前にLytro社から市販され、日本でも多少高価ながらも一般に購入することができた。カメラの常識から考えると撮影したあとにピントが合う位置を変えられる仕組みに驚いたものだ。

そのLytroは残念ながら商業的にはうまくいかず企業としては解散してしまったが、Lytroがもつ特許資産とLytroで働いていた優秀な技術者たちはそのままGoogleに移ったと言われている。そんなLytroの悲願を具現化したのが今回のGoogle Light Field Videoの技術なのかもしれない。

研究開発には、この分野の第一人者であるPaul Debevec氏が数年前Google VRチームに入ったのをきっかけに現在はGoogle Researchに所属し本研究を進めている。

解説動画:Immersive Light Field Video with a Layered Mesh Representation

プロジェクトページ

▶IMMERSIVE LIGHT FIELD VIDEO WITH A LAYERED MESH REPRESENTATION(ページの下部にWebブラウザで見られるデモが多数用意されている。またVRヘッドセットで視聴できるデモプログラムも公開)

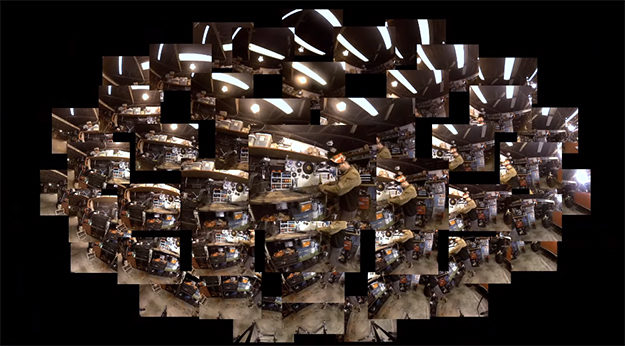

46台のカメラリグで撮影した映像(処理前)

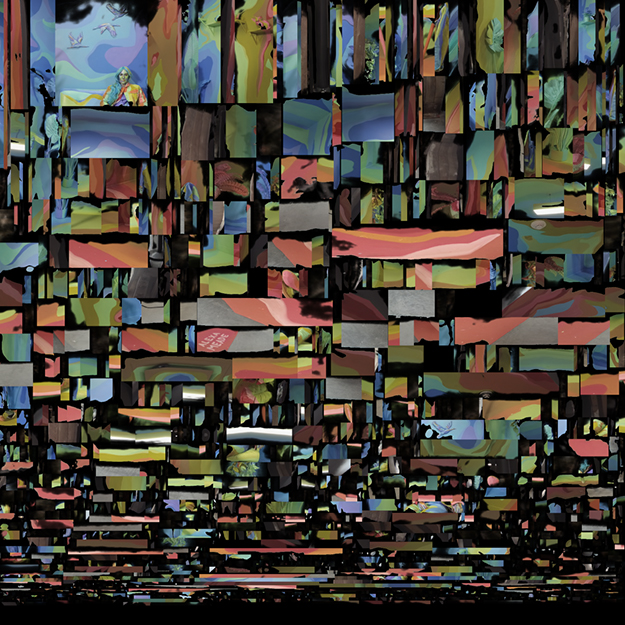

軽量データに変換されWebブラウザ上で視点を動かすことができるライトフィールドビデオコンテンツ

上記データが持っている奥行き情報

Immersive Light Field Videoの撮影装置は、直径92cmの半球ドームの表面に46台の撮影タイミングが同期されたカメラが取り付けられ、昆虫の複眼のような仕組みで奥行きのある現実世界を撮影する。角度1°につき10ピクセル分の解像度を持ち、220°以上の視野を30fpsで撮影することができる(通常のビデオカメラであれば超広角でも120°程度)。

またImmersive Light Field Video技術の従来にはないポイントは、収録した大量のデータを処理し、品質を損なうことなく軽量のデータとして圧縮することでスマートフォンやWebブラウザでもストリーミング再生できる映像データとして取り扱うことができる点だ。

またカメラが46台!で済んでいるのはDeepViewという設置されたカメラとカメラの間を補完する機械学習を活用した技術のおかげだそう。今後はカメラリグを拡張して220°と言わず、360°収録することを目指しているそうだ。

46台のカメラの映像を最適化した上で1枚の画像に圧縮して詰め込んでいる。そのおかげでH.264といった一般的な動画圧縮フォーマットで扱うことができる

このImmersive Light Field Videoの技術は、期待感こそあれ、まだまだ一般的に収録したり視聴したりする段階にはない。けれども4KテレビやVRヘッドセットが想像以上のスピードで普及していることを考えると、一般にもこのような撮影ができるビデオカメラや、視聴装置が普及するのもあと数年のことかもしれない。

昨年のSIGGRAPH ASIA 2019でGoogleの研究チームはThe Relightablesと呼ばれる人の動きを全てキャプチャする仕組みを発表していた。こういった世の中の全てをデータ化する、全てを再現、視聴できるようにするといった一連の研究は、Googleのミッションである「世界中の情報を整理し、世界中の人々がアクセスして使えるようにする」ことの一つにすぎないのかもしれない。本研究はSIGGRAPH 2020のBest in Show/Immersive Experience賞を受賞した。

RealTime Live!より脅威の映像

例年のSIGGRAPHであれば、会場内の一番大きなホールに数千人が集まり、夜の2時間その場で行われるリアルタイムのプレゼンテーションを楽しむイベントが、RealTime Live!であった。

SIGGRAPH 2020 RealTime Live!(全編、登録なし無料で、YouTube公開)

今年はそんなイベントも真の意味でリアルタイムライブ配信になってしまい、各発表者が自宅やオフィスから発表する様子を参加者が自宅でパジャマ姿で観るというイベントとなった。その中でも映像制作技術として注目を浴びた3つの発表を紹介しよう。

■リアルタイムで動画映像を手描きの雰囲気に変換できる技術

RealTime Live!のアーカイブ映像の開始10分あたりからデモを見ることができる

“Interactive Video Stylization Using Few-Shot Patch-Based Training”は、ある1枚の絵を描くと、動画の全てのフレームに描いた絵画風の雰囲気を当てはめてリアルタイムで変換することのできる映像技術。

オンラインの映像配信やVR世界のコミュニケーションではいかに実世界に近づけるか?という観点がある一方、例えば似顔絵や建築の世界では、超リアルなCGよりも、手描きの良さが再認識されている。このデモでは実写撮影した映像を絵画風に扱ったり、映像素材の表現に期待が広がる研究だ。

チェコ工科大学とSnapchatのSnap社による共同研究。

■AIによる顔の差し替え技術(AI-Synthesized Avatars)

Pinscreen Virtual Assistant(Live Demo 2020)

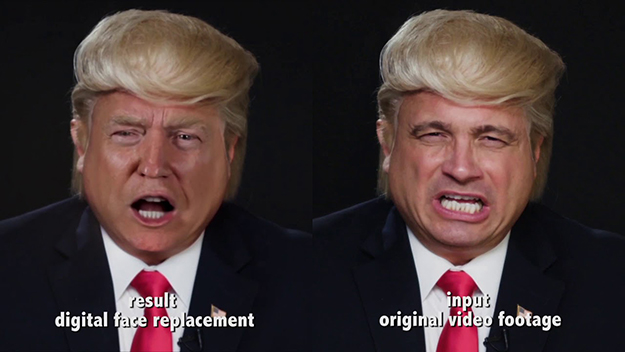

トランプ大統領の顔に差し替えるDeepFake映像

RealTime Live!のアーカイブ映像の開始32分あたりよりデモを見ることができる

Pinscreen社では、メジャーなゲームエンジンとPaGANという機械学習の仕組みを利用し、滑らかな顔アニメーション表現を実現している。RealTime Live!のデモでは映画俳優ウィル・スミスの顔に差し替えたり、Webに掲載されているデモでは顔をトランプ大統領に差し替えたりしたものが公開されている。

トランプ大統領との顔の差し替えDeepFake映像

俳優ウィル・スミスの顔と差し替えてビデオ電話している様子

Pinscreenの技術で差し替え可能なのは顔の部分だけなので、髪型は元のままなのがご愛嬌だが、一見、見間違えるほどのレベルで顔が差し替えられているのも確かだ。大統領など公人の場合、肖像権が生じないことを利用してのデモであり、まだまだ偽物だと見分けることができるレベルではあるのだが、悪用されたり、騙されたりする人が出てくる可能性を考えると空恐ろしさも感じる。

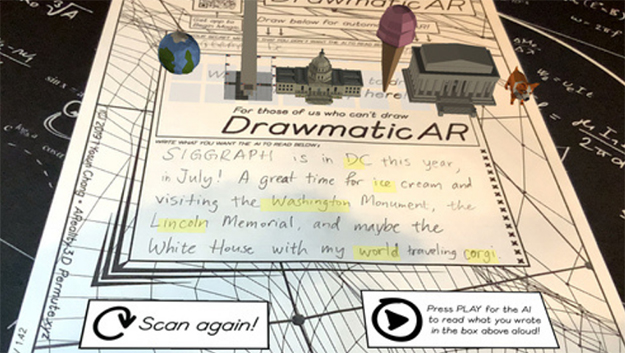

■書いた言葉の3Dキャラクタが登場するARアプリ(DrawmaticAR)

RealTime Live!のアーカイブ映像の開始18分あたりよりデモを見ることができる

DrawmaticARは、iPhone,Androidスマートフォン用のARアプリとして開発されたもので、ARマーカーと呼ばれる認識用の紙の指定の領域に文章(英文)を書くと、そこに書かれた単語を自動認識し、仮想世界でドラマティックなお話が始まったかのように色々な3D物体が登場する技術だ。

技術的にはAIによる文字認識もスマートフォンによる実空間にCGを重ねて表示させるARもそう目新しいものではないが、その2つを組み合わせることで、グッと世界観が広がる技術の応用例だと再認識させられる。もともとは言葉の勉強、ストーリーテリングの学習のため、教育用として作られたアプリ。DrawmaticARはRealTime Live!の観客からの投票が一番多く、オーディエンス賞を受賞した。

今後のSIGGRAPHについて

全てオンラインで開催されたSIGGRAPH 2020のアーカイブ配信は、2020年10月27日まで続く(参加登録はすでに締め切られている)。日本の冬季に開催される「SIGGRAPH ASIA 2020」は韓国のデグ市で開催される予定であったが、今年は全てオンラインでの開催が決まった。通常より少し会期が長く12月4日~13日の9日間開催されることが決まっている。

また、来年のSIGGRAPH 2021は、米国ロサンゼルスで8月1日から5日の5日間開催される予定であるが、現状どのようになるのか全くの未定だ。世界的な未曾有の危機にさらされている現在、だからこそCG/VFX/VRのニーズはますます高まっているとも言える昨今だ。

txt:安藤幸央 構成:編集部