キャスト:笠松将、佐々木美緒

Vaundyの新曲「泣き地蔵」MV制作スタッフへの全8回インタビューは、今回で最終回。最後はTREE Digital StudioのLUDENSとREALIZEのCGスタッフと、CRANKの撮影チーフ古賀達朗氏の6人による対談の場を設けさせて頂いた。これまでのCG制作やバーチャルプロダクションをテーマに、感じたことを存分に語って頂いたので紹介しよう。

CGアセット制作におけるLUDENSとREALIZEの棲み分けとは?

小林氏:2021年1月4日に、デジタル・ガーデン、TTR、メディア・ガーデン、ルーデンスが統合して総合コンテンツプロダクションのTREE Digital Studio(以下:TREE)が誕生しました。LEDディスプレイに映し出す3DCG映像の制作には、TREEのLUDENS事業部とREALIZE事業部の両方が関わっています。そこはどのように棲み分けをされていますか?

平嶋氏(REALIZE):

主にREALIZEチームはBlueprintなどのテクニカルな部分を担当し、ビジュアル部分などのCG制作はLUDENSが制作しました。もともと、CG・VFXをはじめとする映像制作を担うのはLUDENS、新たな映像表現を目指すコンテンツ制作はREALIZEという棲み分けはありました。

小林氏:2021年1月にTREEとして一つになって棲み分けができたというよりも、元々そのようなジャンルを手掛けていた感じですか?

山田氏(LUDENS):

TREEの前身の会社で株式会社デジタル・ガーデンというポストプロダクション業務をメインとする会社がありました。そこにCG部門のVisual Communication Design Dept.があり、その時代からVR、ARをはじめとしたインタラクティブコンテンツを手掛けていました。

小林氏:ということはどちらかというとUnreal EngineよりもMayaとかメインツールのような感じでしたか?

山田氏(LUDENS):

そうです。CG発信ですね。

小林氏:Unreal Engineに関しては、今回の案件以前から手掛けていたのでしょうか?

平嶋氏(REALIZE):

Unreal Engineはかなり初期から注目しており、旧デジタル・ガーデン時代の2015~2016年頃から用いています。

小林氏:リアルタイムレンダーはそれまでどのようなときに必要とされていましたか?

平嶋氏(REALIZE):

ゲームに近いインタラクティブコンテンツ制作のような時に使用していました。プロダクトやコマーシャルの現場からCGをもらうことがありまして、それを活用できないかみたいなことでスタートしました。

山田氏(LUDENS):

インタラクティブコンテンツ制作には、業界の中でもいち早く取り組んできたと自負しています。リアルタイムの描画に関しては、いろいろソフトを試して可能性を常に探っていました。

そういうところからスタートしているので、リアルタイムに作られるCG映像に対して拒否反応とかはありませんでした。要はCMの考え方は、短時間でクオリティが出せれば手法は特に問いません。そんなひとつの選択肢として始まりました。

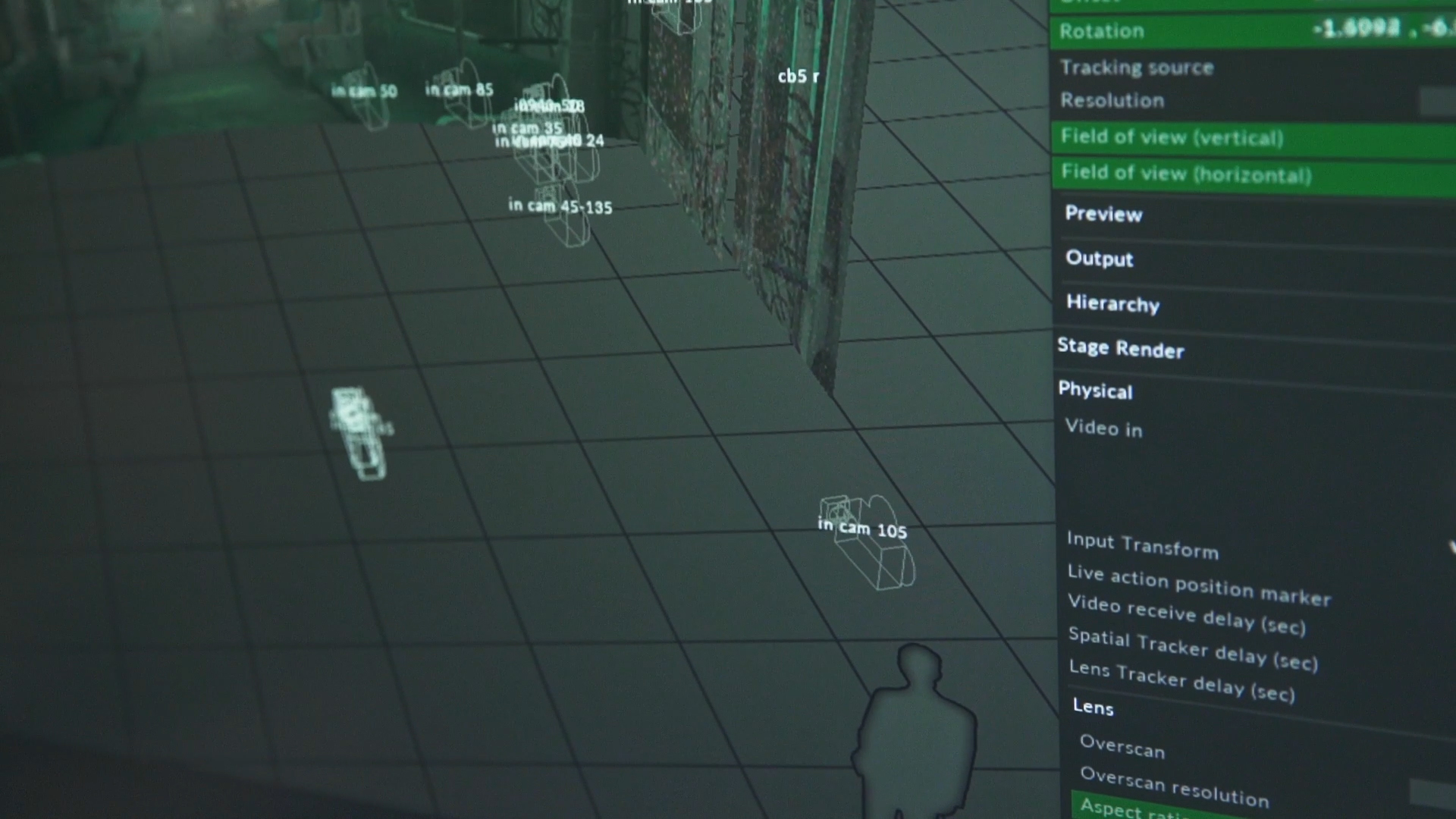

Unreal Engineで背景のCGシーンを実現

小林氏:TREE内での棲み分けとしては、REALIZEの方がプログラム寄りでLUDENSの方がグラフィカルやデザインという棲み分けであることはわかりました。それで本MVのCGに関しては、オリジナルでモデリングした部分はどれくらいありますか?

YUAN氏(LUDENS):

電車の中はほぼ作りました。

平嶋氏(REALIZE):

駅の中は、監督が前に作られていたアセットをいただいて、それをベースにしている感じです。ホームも、オリジナルです。

小林氏:それはどのようなツールで作りましたか?

YUAN氏(LUDENS):

モデリング自体はMayaで、テクスチャはsubstanceなどを使いました。

小林氏:モデリングの作業とUE4でのシーン作成はそれぞれ侵食する分はあったのでしょうか?

山田氏(LUDENS):

いえ、ソフトウェアをまたぐ作業に関しては曖昧ではなくて、「プログラムチーム」「ビジュアルを作るチーム」で完全に分かれています。YUANがプログラムを書くことはほぼないですし、根岸がモデリングをすることはありません。

小林氏:ではREALIZEが作成したモデリングデータをLUDENSでUnreal Engineのプロジェクトとして構成するという流れですね。

YUAN氏(LUDENS):

そうですね。モデリングができたらUnreal Engineに持っていき、ワールドを構築、ライティングするまでがLUDENSです。

平嶋氏(REALIZE):

例えば今回のMVでいうと、電車のつり革が揺れていました。その揺れは単純にアニメーションではなく、プログラムだと簡単に実現することができます。

そういう部分を根岸がコントロールしました。YUANが「こういう風に動かしたい」という指示を根岸にリクエストして、根岸が実現する流れでした。

小林氏:揺れの演出は、シェーダーで揺らす、物理的に揺らす、と二通りありますがどちらで行っているんでしょう?

根岸氏(REALIZE):

つり革はローテーションの角度をずっと計算しています。

小林氏:ではUnreal Editorで再生をクリックすることでつり革が揺れだすという?

根岸氏(REALIZE):

そうです。

小林氏:通常のグリーンバック撮影では、撮影時の照明に背景のCGの照明を合わせていきます。しかし、今回は事前に作ったシーンをLEDディスプレイに投影し、現場で照明を組んで撮影しています。現場の撮影時にCGの修正などあったのでしょうか?

YUAN氏(LUDENS):

色味と温度感、コントラストの強さなどを修正しました。現場で実際に照明がセッティングされた状態で確認をしたところ、やはり修正したいところがありました。Unreal Engineにポストプロセスエフェクトというグレーディングのような調整が可能な機能がありまして、そちらで調節を行いました。

バーチャルプロダクションは現場のコミュニケーションがポイント

小林氏:ヒビノのHibino VFX Studioで3回テストしていると思いますが、どのようなことをチェックしましたか?

古賀氏(CRANK):

ヒビノのスタジオではLEDのピッチを確認したり、モアレの発生の有無を確認しました。

小林氏:テスト撮影時は?

古賀氏(CRANK):

テストの時点から本番と同じARRIのALEXA Mini LFとシグマのシネマレンズでチェックをしました。

小林氏:さすがCRANK!

山田氏(LUDENS):

CRANKというよりも、TREE社内だから実現できたことですね。

小林氏:テスト数回と準備+本番と、それだけのスケジュールでALEXA mini LFを使えるのは羨ましいですね。

平嶋氏(REALIZE):

演出的には確かに多少変わった部分はありますが、その時点でライティングも入れていただいて、何度もテストを行いました。

こちらでカメラマンさんと監督と相談しながら直したので、本番で急に色々なことが変わることはありませんでした。

小林氏:CG業界と撮影現場では話す文法が違うと思いますが、そこらへんの話をつなぐ役割は古賀さんが担当したと聞きましたが、どうだったのでしょう?

古賀氏(CRANK):

正直、僕がCG、Unreal Engine、システムのことに関して初めてだったこともありますし、全て理解できたわけではありません。しかし、ヒビノさんチームには僕の言葉で問題点やよりよくするための提案をし、理解していただきました。言葉は違いましたが、まったく伝わらなかったということはありませんでした。

小林氏:どのようにすればリアリティが出るか?実際に撮影している現場の人間だから気付くことがあると思いますが、具体的にどのようなやり取りでしたか?

古賀氏(CRANK):

フォーカスの深度感の調整は実際の本番でもやってもらいました。そこがひとつ難しい部分で、テストを3回できたのはよかったと思っています。

カメラのレンズの絞りをどの程度にしておけば馴染むのか?レンズの絞りを決めたうえで、CGの中の世界とも連動しているのですけれども、そもそもの深度感がカットごとにレンズを変えることによって馴染まないときもあり、そこは正直感覚で対応しました。

平嶋氏(REALIZE):

disguiseの中でも、厳密に合わせていけば実際のカメラのボケ感をF値によってシミュレートすることは可能ですが、実質そこまで追い込めていない状況でした。

本当はきちんとF値を入れて、シャッタースピードを入れて、レンズのmm数を入れれば、同じボケ味になるところまで追い込める機材ではありますが、今回はまだそこまではできていないのが実情でした。

小林氏:あと、MIZUNO監督が作ったYouTubeのデモ映像の完成度が高くて驚きました。あのような作品を作れる方が監督でプレッシャーを感じたことはありましたか?

平嶋氏(REALIZE):

プレッシャーはほぼなくて作業がやりやすかったです。CG出身の監督ですので専門用語で伝わるし、あとこちらの苦労を察してくださる(笑)。

山田氏(LUDENS):

「これって大変ですよね」が通じるんです(笑)。

平嶋氏(REALIZE):

しかも指示も明確だし、大変わかりやすい監督でしたね。

小林氏:どちらかというと撮影現場よりもCGに強い印象ですね。

古賀氏(CRANK):

僕ら撮影部的にやりづらかったことはありませんでした。

監督が常に現場でイメージを的確に伝えてくれたので、僕らもそれを実現するための作業がしやすかったです。

バーチャルプロダクションはLEDディスプレイを境界線にしたCGと撮影現場の綱引きである

小林氏:現場を振り返ってみて、「こうしたかったのにできなかった」と思うことがたくさんあると思います。最後に、バーチャルプロダクションの感想や、今後の改善点を挙げていただけますか?

平嶋氏(REALIZE):

照明的なことですが、Unreal Engineはゲーム制作のためのソフトウェアで、副産物的にVFXで使われることが増えてます。しかし、もともとの考え方はリアルタイム表示するためのもので、プリレンダリングの考え方はやはり薄いです。光の考え方も、ゲーム寄りの考え方を取り入れています。

つまり、変化しない影の部分や光の反射などはレンダリングされたものを貼り付けるなどして、いちいち計算をかけず、ある程度処理をショートカットさせることで描画の速度を上げているのがUnreal Engineの考え方です。

小林氏:実際照明が終わった段階のテクスチャを貼り付けているみたいな考え方ですよね?

平嶋氏(REALIZE):

そうですね。つまり、光の当たり方などを事前にシミュレートしている感じです。対して、V-Rayなどのレンダラーは、きちんと物理的に正しいライティングを計算していきます。なので、ライトが変われば計算結果が変わるので、すべてレンダリングし直しになります。

Unreal Engineは事前に計算しているので、ライトを変更しても影響が出ません。もしくはかなり大きく変えたければ事前に計算を一度やり直さなければいけません。となると、現場で変えられることは限られてきているのが今の実情なのです。

これを解決するのはハードウェアの進化しかなく、ハードウェアが高速になれば、この2つの境界も限りなくなくなり、変更しても一瞬で反映させられる時代が恐らく数年以内には来るのではないかなと思います。

小林氏:Unreal Engine 5.0の登場によってもだいぶ変わりそうですね。

平嶋氏(REALIZE):

だいぶ変わると思います。今のNVIDIA AシリーズのGPUも大幅に高速化され、相当処理速度は跳ね上がることが予想されます。おそらくもうあと何世代か後のGPUとUnreal Engine 5.0の組み合わせで、リアルタイムにレイトレーシングすべての計算ができるのではないかと予想されます。

そうすると恐らく待ち時間はなくなります。何ルーメンの照明をここに置いたら、それと同じ光のシミュレートができるようになるでしょう。CGデザイナーがUnreal Engineを触る必要性があまりなくなり、照明技師が直接Unreal Engineの中でライトを組めばいいし、美術デザイナーはそこでセットを立てればいい時代がくるかもしれません。

そういうツールになっていくのではないかと思っています。そうなるとバーチャルプロダクションに対する関わり方が変わるのではないかなと考えています。

石ヶ谷氏(REALIZE):

バーチャルプロダクションは選択肢の一つであり、今回の「泣き地蔵」MVでは、当初すべてバーチャルウォールを使って撮影していく予定でテストを行いました。

しかし、「やはり美術だけでやろう」というシーンもでてきて、金網シーンは美術だけでした。バーチャルウォールが適しているシーンもあり、それがわかれることによって作品のクオリティも上がってくる。つまり「用途」によっての使い分けです。それも複数回テストを行って次第にわかってきました。

また、バーチャルウォールは3mの高さがあっても、カメラを引くと画角が足りず、ポストで合成してもらうことになりました。今回はグループ会社のAOI Pro.だったのでTREE社内でもうまく連携できましたが、今後カメラマンさんや照明部さん、美術部さんでトータル的に理解を深めていくのは必要だなと思いました。

山田氏(LUDENS):

結局バーチャルプロダクションは、どこがゴールなのか?みたいな話になると思います。今はCGの世界を無理やり撮影側のところまでギリギリまで引っ張り出している状態じゃないですか?それをバーチャルプロダクションと呼んでも、僕はいまいちピンと来なくて、綱引きになっていると思います。

小林氏:綱引きですか、それはCGの現場と撮影現場との?

山田氏(LUDENS):

そうです。LEDディスプレイというのが見た目上でも分かりやすいですが、LEDの向こう側がCGの領域。LEDのこっち側が撮影の領域といった具合に綱引きの勝負ラインにもなっている。そこで両者が引っ張り合いをしているイメージです。

この先の話をすると、先ほど平嶋が言ったように、CGの計算速度が上がって、ライティングもポンって置いたらリアルと同じようになると予想しています。

さらに言えば、実際のライティングもせず、カメラも置かずに、完全にCG空間の中で撮影からライティングまで行われるのが、「真のバーチャルプロダクション」だと思っています。

将来的にはフルバーチャルとなり、実際と変わらないものが完全バーチャル空間でできるようにならないとツールのひとつとしては選択されないと思います。

今後、制作予算を増やすのは難しいでしょうが、それでも「処理が遅くなります」とか「クオリティが落ちます」は絶対なくて、高速かつきれいになっていくことが求められるでしょうね。

小林氏:「綱引き」っていう表現がすごくわかりやすいですね。確かにCGの世界と撮影の世界で、今まで本当に話す言葉さえ違っていた人たちの境界線にLEDがあるということですね。

古賀さん、根岸さん、YUANさんはいかがですか?古賀さんはバーチャルプロダクションが今回この案件が始めてでしたのですよね。

古賀氏(CRANK):

はい。グリーンバックはありまして、グリーンでのバーチャルプロダクションも経験したことがあるのですけれども、LEDでの撮影は初めてでした。完全に答えは出し切れてないんですけど、まだやれてないいろいろな可能性があるのではないかと思っています。

根岸氏(REALIZE):

私自身、エンジニアなので撮影に関しての知識がまだありません。しかし今後は、現場との垣根がなくなってきて、エンジニアも撮影現場に立ち会うのが必要だと思っています。僕らもおそらく、撮影側に歩み寄っていく必要があるのではないかと思ってます。

YUAN氏(LUDENS):

CGによるバーチャル世界となると、CGデザイナーとしてもカメラと照明についてもっと勉強しなければならないと感じています。

今回のMV「泣き地蔵」でも、ライティングとリアルタイムで再生させるためのモデリングデータの軽さとクオリティのバランスを追求しましたが、まだまだ最適化して軽くできる余地はあると思います。さらなる技術の向上を目指していきたいと思います。

小林氏:今日はありがとうございました。

小林基己

MVの撮影監督としてキャリアをスタートし、スピッツ、ウルフルズ、椎名林檎、リップスライム、SEKAI NO OWARI、欅坂46、などを手掛ける。映画「夜のピクニック」「パンドラの匣」他、ドラマ「素敵な選TAXI」他、2017年NHK紅白歌合戦のグランドオープニングの撮影などジャンルを超えて活躍。バーチャルプロダクションのVFXアドバイザーの一面も。noteで不定期にコラム掲載。