バーチャルプロダクション(LED In-Camera VFX)は、空間内でのカメラの位置をリアルタイムにトラッキングして、その視点から環境画像をCGでレンダリングし、実写の撮影空間に、仮想世界の環境をリアルタイムに投影できる話題の手法だ。このまったく新しい環境を実現する原動力になっているのが、Epic GamesのUnreal Engineである。

今回は、エピック ゲームズ ジャパンの向井秀哉氏と杉山明氏にオンライン対談のご協力を頂き、バーチャルプロダクション+Unreal Engineの最新状況を聞いてみた。

Unreal Engineでなぜバーチャルプロダクション?

小林氏:今日は時間を作っていただいてありがとうございます。まず、Unreal Engineの近況(4.27と5.0)を教えてください。

向井氏:

Unreal Engine 4.27では、様々な業界向けた機能の追加やアップデートを行っています。GPU LightmassのマルチGPU対応、Lens Distortion、Production-Ready(正式実装)になったPixel Streaming、また、RAD Game ToolsがEpic Gamesに加わり、Oodle Compression SuiteとBink Videoの追加など多くのアップデートがあります。

特にLEDウォール技術を使用したバーチャルプロダクションプロジェクトの増加に対応するため、In-Camera VFXで使用するツールの改善に重点が置かれました。ワークフロー、LEDウォール上の画像を処理する技術、サンプルプロジェクトのリリースなど多くの作業を行いました。

UE5は、現時点では早期アクセスの状態です。これは、ユーザーのプロジェクトが市場に出るまでにかかる時間を考慮して、新技術への対応を一足先に始められるようにしたかったからです。先日開催されたCEDEC 2021では、UE5 早期アクセスの注目機能を紹介しています。

小林氏:Unreal Engineの4.27アップデートでは、「Unreal Engine 4.27新機能ハイライト」にバーチャルプロダクション機能が筆頭として紹介されています。4.27でバーチャルプロダクション関係の大幅な強化を行ったのはなぜでしょうか?

向井氏:

「マンダロリアン」の人気や、パンデミックによる撮影環境の変化に伴い、LEDウォールを使用した作品や、そのような撮影方法を予定している作品が急増していることを実感しています。それらに対応し、映像制作技術の最先端を走り、これらの技術を使用する映像制作者をサポートし続けることが重要でした。

GPUの性能向上とUnreal Engineのアップデートにより、映像制作者はより複雑なシーンを撮影したり、よりワイド(広角)なレンズを使用した撮影、複数のカメラで撮影ができるようになりました。

しかし、これは多くの技術を用いた複雑なプロセスでもあります。そのため、映像制作者やそのチームがテクノロジーではなく、本来の制作に集中できるものにしたかったのです。そのことから、最終的に4.27はツールの自然な進化であると同時に、Unreal Engineを映画制作、映像制作に使用している人たちの真のニーズから生まれたものだと思います。

小林氏:おそらくUnreal Engineの出力をLEDディスプレイに投影してバーチャルプロダクション手法を実現する人は、Unreal Engineユーザーの中でもほんのわずかだと思います。それでも4.27にバーチャルプロダクションの機能をメインに出したのはどのような理由からですか?

向井氏:

割合は把握できていませんが、もともとノンゲーム全般または映像に関しては力を入れています。

その一環として、先ほど申し上げた通り、バーチャルプロダクションがより広まってきた中で、アーティストの方、撮影に関わる方がより使いやすいように、制作に集中できるようにした結果、4.27では、バーチャルプロダクション向けの機能がメインになりました。

小林氏:自分たちの撮影現場にとっては大変嬉しいことですが、ここまでニッチなターゲットに向けてアップデートを続けるのは大変なことだと思います。さらに、映像の分野に関しては、現在無料で使えるのは太っ腹だなと思いました。

それで、Hibino VFX StudioとVGIでもバーチャルプロダクション手法の撮影をやらせてもらいました。ヒビノはdisguiseを使用しています。それで初めてVGIの現場でUnreal Engineだけの現場を4.26で使ったときに、「だからdisguiseやSMODEが選ばれる」ということがわかりました。

しかし、nDisplayとエディターのコンビネーションに関しては、4.27で大きく解決しました。さらに、4.27でdisguiseなどにより近い使いやすさを実現しているように見受けられますが、そのあたりはいかがですか?

向井氏:

4.27でdisguiseの機能を追加したわけではありません。disguise特有の機能を使いたい場合は、現状ももちろんdisguiseを使っていただいた方がよいと思います。それとは別に、4.27ではnDisplay関連が進化しています。

小林氏:disguiseはマルチユーザーでエディターで編集したものをそのままで出すことは可能でした。それが4.26の時はまだできなかったと思いますが、それは自分たちのやり方が間違ったのか?実際にそうだのか?どちらですか?

向井氏:

マルチユーザーの編集という意味ではできました。ただし、nDisplayとエディターを両方立ち上げてエディターで修正して、そのままnDisplayに反映するという意味では4.27はより使いやすくなっています。

小林氏:グラフィックボードに関しては、GeForceよりもQuadroの方が理想的ですか?

向井氏:

GeForceでも問題ありません。しかし、グラフィックボードにより性能が異なります。より高い解像度をLEDディスプレイに出力したい場合は、それなりの性能が必要になってきます。

杉山氏:

グラフィックスボードに関しては、複数台PCをレンダリングノードとして用意して、例えば背面と天井横や高解像度出したいときにnDisplayを使うのですが、同期を取るときのことを考えるとQuadroを推奨します。

小林氏:あと重要なのはトラッカーです。トラッカーは、これまで見てきたスタジオでは、RedSpyやmo-sysのStarTracke、VIVEトラッカーなどが対応していました。

VGIの現場では、インテルのRealSenseを使いました。RealSenseではプラグインが用意されてなくて、VGI自身が独自に開発して対応する形でした。この他にどのようなトラッカーに対応していますか?

杉山氏:

Ncamにも対応しています。NcamのWebページには、列車1台分をLEDウォールで囲んだメイキング動画が公開されています。

Ncamのトラッキングもそうですが、基本的にはトラッキングメーカーの方でプラグインを開発していていただきます。Epic Gamesが開発しているものではありません。

小林氏:あと、「マンダロリアン」の時は、VICONでしたね。

杉山氏:

おそらくそうだとは思います。ただし、詳しいシステムは公開されていません。メイキング動画を見る限りではVICONでした。レンズデータをどのように取り込んでいるのかまでは公開されていないので不明ですが、カメラの角度、位置はVICONで行っていたと思います。

Unreal Engineでプレビズが変わる

小林氏:よくUnityはプログラムを理解している人向け、Unreal Engineはビジュアライゼーションまたは違う領域からの人でも入って行きやすいという話を聞きます。確かに自分は映像の方から入ってきたのですけど、実際に操作してみるとUnreal Engineはわかりやすかったです。

それで、特にわかりやすかったのは3DビジュアライゼーションソフトのTwinmotionでした。導入はTwinmotionで、それで自由度がない分をUnreal Engineで、と思ったら意外と大変でした。Twinmotionのカメラ設定がUnrealEngineのようになってくれたら理想と以前から思っていますが、そのあたりはいかがでしょうか?

杉山氏:

放送業界のセットデザインにSketchUp、Vectorworksを使っているお話をよく聞きますが、そのデータをVRとして見せるときにどのようにするのかが問題になるようです。そのような時にきれいな画で出力したい場合は、それらと連携がしやすいTwinmotionが便利だと思います。

また、Twinmotionで作ったものをUnreal Engineにインポートできるようになっています。例えば、たたき台をTwinmotionで作って、よりインタラクティブなコンテンツとか、リアルタイムレイトレーシングを使いたい場合はUnreal Engineに持っていく、ということはさまざまな業界でムーブメントとしてあります。

小林氏:最終的なレンダリングは品質はTwinmotionよりもUnreal Engineのほうが優れている感じですか?

杉山氏:

TwinmotionもUnreal Engineベースでそれをカスタマイズしたものです。2021年3月末にリリースしたTwinmotion 2021.1は、Unreal Engine 4.26をベースに作られていています。

次のバージョンでは、Unreal Engine 4.27がベースになります。4.27の新しい機能をTwinmotionに継承できる流れは組まれています。ただ、現在はリアルタイムレイトレーシングはTwinmotionでできないので、Unreal Engine側を選ぶことになりますね。

小林氏:次にTwinmotionクラスの使いやすさで、ぜひプレビズ用のソフトウェアの登場を期待したいです。簡単にオブジェクトと人物だけ配置して、大体のカメラワークを見せたい場合に、Twinmotionを使うこともあります。

プレビズをUnreal Engineで作っておくと、背景もよりブラッシュアップしたものを、そのままLEDウォールのスタジオに持っていったり、プレビズで作ったものを一回捨てて、また再構築ではなくて、継承できる資産は継承してファイナルのまで引き継いだほうが無駄も少ないように感じます。

さらに今後、LEDディスプレイを使ったバーチャルセットにするのか?ロケにするのか?グリーンバックにするのか?という選択肢になって来た時に、それがプレビズからの連動になってくると判断がしやすいと思います。バーチャルセットのほうが流れがスムーズになり、より選択される可能性も上がるのでは?そんなことに少し期待してる部分もあります。

向井氏:

仰る通りで、プレビズでの利用も多く、従来より品質の高い状態でプレビズができます。また、VRを使用したバーチャルスカウティングというCG空間でのロケハンのようなこともできます。そういった面でもプレビズの時点や、それ以降の最終系に近い時点でも、役立つのではないかと思います。

4.27で搭載された新機能とは?

小林氏:バーチャルスカウティングの際にも、4.27の新機能が使われてきそうですか?

向井氏:

はい。4.27では、バーチャルカメラのためのiOSアプリを改善し、新しく「Live Link VCAM」というアプリをリリースしました。タッチスクリーンに加えて、コントローラーやその他のハードウェア入力やエディタでのマルチユーザー編集などをサポートしました。

Live Link VCAMアプリは、プレビズやフルCGのコンテンツ全般に向けたものです。このアプリは、iOSデバイスの位置や回転などの情報をリアルタイムでUnreal Engineのカメラに反映します。つまり、カメラマンが実際にカメラを持って撮影するのと同じように、バーチャル空間を撮影することができます。

将来的には、実写制作により適した別のバーチャルプロダクション用アプリを開発するかもしれませんが、現在のこのアプリはIn-Camera VFXと同時に使用することは想定していません。

しかし、バーチャルプロダクションのプロジェクトでも、LEDボリュームを使用する前のプレビズやバーチャルスカウティングに役立ちます。

小林氏:iPhoneやiPadでできるのは大変手軽だと感じました。

向井氏:

アプリが用意されているので、それをインストールするだけでできますね。

小林氏:LEDディスプレイの外側の足らない部分をオンライン編集で合成するために、撮影後にカメラの画角全体のCG出力をレンダリングしたものを合成するというケースもいくつか聞きます。しかし、同じシーンで同じカメラアングルのCGとはいえ、撮影後の映像は、LEDプロセッサーの出力や実際にカメラを通している映像だから、CGだけでレンダリングした映像の色味や画質をマッチングさせるのが大変だと聞きました。

向井氏:

4.27では、In-Camera VFXで必要不可欠なnDisplayでもOCIOをサポートしました。これにより、制作者はLEDプロセッサーやLEDウォールの影響を考慮して、Unreal Engine、LED、カメラ間のカラーパイプラインを予測でき、一貫したカラーマネジメントが可能です。

小林氏:iPadによるWebリモートコントロールも4.27から対応ですか?

向井氏:

Webリモートコントロール自体は4.26より前から搭載されていますが、4.27でも更新されています。

ちなみに、Webリモートコントロールは、iPadやPCなどのウェブブラウザから、オブジェクトの位置や設定などのプロパティを変更することができる機能です。

以前は、ウェブ関連の知識を持つエンジニアがUIを構築する必要がありました。しかし、リモートコントロールWeb UIビルダーでは、アーティストがUnreal Engineで、公開したい項目を選択し、あらかじめ用意されているUIをD&Dで配置するだけで、コードを一切書くことなく、ブラウザからコントロールすることができます。

オペレーターではない撮影監督や照明技師がライティングやオブジェクトの位置などに調整加えたい場合などに活躍しています。

小林氏:そのほかの大きな変化でいうと、GPU Lightmassがありますが、バーチャルプロダクションにも関係あるのでしょうか?

向井氏:

実際にプロダクションの現場でライティングを変えたいときや、オブジェクトを動かしたい時に、再度Lightmassを用いて、ライティングの情報を再計算する必要があることがあります。そういった時は、GPUで計算するほうが高速です。

CPU計算のCPU Lightmassでは、数時間かかっていた計算が、GPU Lightmassでは、数分で済みます。そのため、現場での待ち時間を減らすことができます。

GPU Lightmassを使用するには、Unreal Engineでレイトレーシングを使用するためのハードウェアなどの要件を満たす必要がありますが、リアルタイムレイトレーシングそのものではありません。しかし、リアルタイムレイトレーシングと併用することができます。

また、CPU Lightmassでは、描画されなかった頂点カラーによりGIの描画やプログレッシブでの計算などもサポートされています。

小林氏:4.26で実際にLEDに出力されている映像を見ながら、シーンを編集できないことに大変ストレスを感じたのですが、その点が大幅にやりやすくなっているのではないかという期待感があります。

あと、少し言いにくいことかもしれませんが、ゲームの場合は決まった売り上げ以上の収益に応じてEpic Gamesにロイヤリティを支払うことで利用が許されています。ただし、エンタープライズ系は凄い曖昧ではないですか?

向井氏:

BtoBでは、基本的には無料でご利用いただけます。確かに、その線引きが難しいプロジェクトもあるかと思いますので、不安要素やご不明点がある場合は、お気軽にご連絡頂ければと思います。

小林氏:今は大丈夫ですが、今後いかがですか?撮影現場向けのUnreal Engine Studioとか、特別なエディションが登場したりすることはありそうですか?

向井氏:

将来のことはコメントできませんが、現在のところ撮影現場向けのプランとしては特に設けていません。

小林氏:4.27について、杉山さんから何かありますか?

杉山氏:

今回はバーチャルプロダクション周りの改善点が多かったですが、特にそれ以外がおざなりになるわけではありません。たまたま今回はこのような形なだけで、もちろんゲーム系は当たり前ですし、自動車系、建築系の改善も積極的進んでいくと思います。

4.27の目玉となる機能としては、まだベータですがパストレーサーがあります。リアルタイムレンダリングではなく、一コマ一コマに時間を要するオフラインレンダリング的な使い方になります。

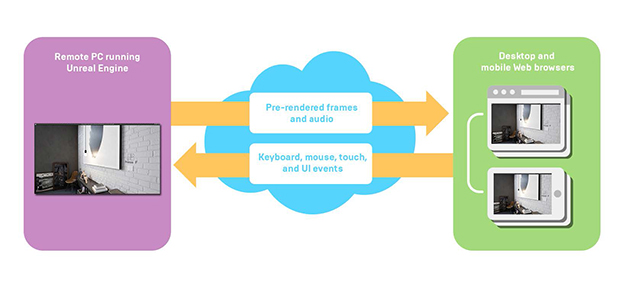

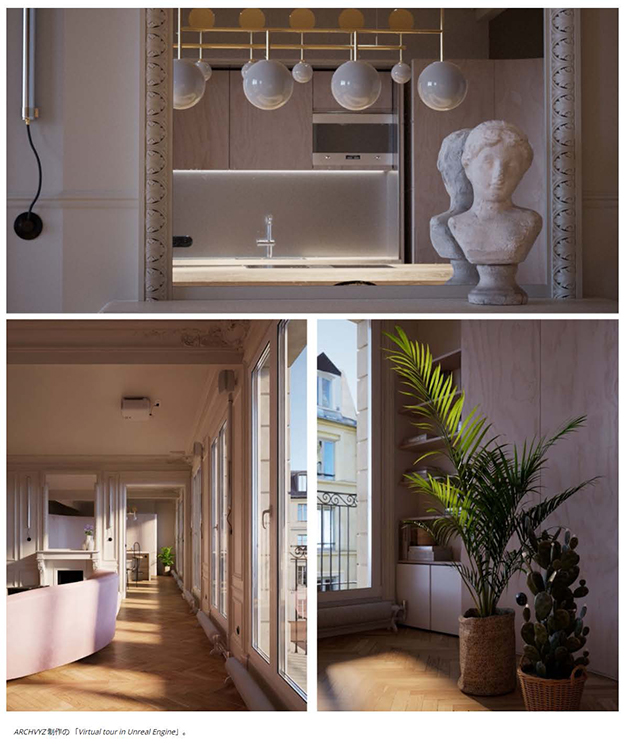

あとは、バーチャルプロダクションでの活用は難しいかもしれませんが、Pixel Streamingがあります。長い間ベータ状態が続いていたのですが、ようやくプロダクションレディーになりました。

クラウドを使ったMetaHuman CreatorやTwinmotionクラウドもそうですけども、クラウド上にUnreal Engineのプログラムを置いて実行し、ユーザーは、インターネットコネクションとWebブラウザがあれば、Unreal Engineのリアルタイムのコンテンツを体験できる機能です。

クラウドを使うケースはどんどんと増えていく傾向にあり、その辺も力を入れています。

小林氏:パストレーサーの登場で意外だと思ったのは、従来のUnreal Engineはゲームエンジンとしてリアルタイムで勝負してるわけですよね?それがプリレンダーの部分に力を入れたということは、今後CGアニメーションに使うこともできます。Mayaや3ds Maxなどとレンダラーという意味では競合にもなってくると思うのですけれども、その辺りを見据えている感じでしょうか?

向井氏:

競合と見据えているわけではありませんが、先ほど杉山からあった通り、より高品質な映像が作れるようにしたいと思っていますし、よりCGアニメーション、映像制作で使っていただきたいと思っています。

小林氏:Unreal Engineは、いつも何か新しいことができる、時代を切り開いていく印象をいつも受けます。それは撮影方法にしても、建築などの分野やMetaHumansなどでもそうですが、何か社会のシステムを変える存在なのでは?と感じています。

だから、ゲームエンジンだけではなくなっている感じがして、それを無料で提供するという。どれだけの慈善事業なのか?という(笑)。そんな感じで今後の展開を期待していきたいと思います。

ありがとうございました。

小林基己

MVの撮影監督としてキャリアをスタートし、スピッツ、ウルフルズ、椎名林檎、リップスライム、SEKAI NO OWARI、欅坂46、などを手掛ける。映画「夜のピクニック」「パンドラの匣」他、ドラマ「素敵な選TAXI」他、2017年NHK紅白歌合戦のグランドオープニングの撮影などジャンルを超えて活躍。バーチャルプロダクションのVFXアドバイザーの一面も。noteで不定期にコラム掲載。