Virtual Production Field Guideでは、これまで日本に上陸してきたバーチャルプロダクションの各社スタジオを軸に紹介してきた。今回は、バーチャルプロダクションの現場で活躍するスタッフに話を聞く。バーチャルプロダクションの基本知識や機材のトレンドについて、テクニカルディレクターとして活躍するsync.dev代表の岡田太一氏に話を聞いた。

岡田太一|プロフィール

1982年生まれ。テクニカルディレクター/フィルムエディター。CGIジェネラリストからキャリアをスタートし、フィルムエディターに転身。CM業界において一通りのポスプロ工程を経験し、2012年STUD Co., Ltd.設立。2019年R&Dチームsync.devを設立。以降映像制作だけでなくUnity/UE4によるリアルタイムCG案件をメインに、バーチャルプロダクション関連の構築、R&Dに注力。

バーチャルプロダクション本番環境を事務所で再現する実験室を構築

――岡田さんが代表のsync.devとは、どのような会社ですか?

岡田氏:

弊社は2012年にポストプロダクションのSTUDを開設しまして、テレビCMのオフラインやオンライン編集をメイン業務としてきました。例えばですが、STUDは私が代表で私自身はCGデザイナーからキャリアをスタートしたこともあり、これまでとまったく違う領域にチャレンジしても、「ポスプロさんね」という風に思われてしまいます。そこで異なる社名でスタートしたのがクリエイティブチームのsync.devです。

社名にはデベロップメントやR&Dを手掛けたい思いを込めまして、今までにない表現や誰も実現していない製品開発に挑戦したいと考えています。

――バーチャルプロダクションに関係する実績には、どのようなプロジェクトがありますか?

岡田氏:

公表できない受注案件がかなりあります。最近ですとアスク メディア&エンタープライズ事業部主催のイベント「Hello, New World」などがあります。こちらではUnreal Engine周りをサポートしました。そのほかには、自動車メーカーの発表会やeスポーツ大会などもテクニカルディレクターとしてやらせていただいております。

どの受注案件でもZero DensityのRealityを使うことが多いのですが、そもそもRealityはUnreal Engineをベースに稼働しています。しかし、まだまだ皆さんUnreal Engineについてそれほど理解していません。例えば、CG会社さんにUnreal Engineのシーン制作を依頼することが増えていますが、作ったものを会場やスタジオに持ってきて、さあ動かそうとしても動かないことが多いのです。

実はUnreal Engine側やReality、さらにスタジオとの話をすべて理解していないと、実現できないことがあります。このような現場の橋渡しに私達がテクニカルディレクターとして入らせていただくことがあります。

――興味を引いたのはバーチャルプロダクションの実験室です。なぜ、社内に実験室を構築したのでしょうか?

岡田氏:

sync.devの案件には、もちろんバーチャルプロダクションを使ったイベントや撮影があります。そして以前、Zero Densityとグリーンバックの現場で悩まされたのは、手元に実験環境がないために現場に行ってぶっつけ本番みたいになることでした。

現場によっては1日あたり100万円以上のスタジオ料金がかかり、撮影部や特機部と合わせて何10人もスタッフが入ってる状態で、機材を構築して稼働させなければいけないのは、コスト的にもプレッシャー的にも半端ないものがあります。そんな経験から現場と同じ状況を事務所に作って検証を終わらせて、現場に行って仕込みを1日終わらせるための実験環境が必要と思い、構築に至りました。

――なるほど。では、ここで再現した機材を現場にそのまま持ち込み可能ということですね。

岡田氏:

あります。PCは移動を想定してアルミケースに入れて移動できるようにしています。しかし、当社単体でバーチャルプロダクションのすべてをまかなうことは少なく、一緒に手掛ける協力会社さんによって相手のマシンを使う場合もあれば、必要であればここのマシンを使う場合もあります。当社としては、基本的に実験環境がまず必要ということでした。

――こちらの実験室では、どのような機材を使っていますか?

岡田氏:

ソフトウェアに関しては、基本的にUnreal Engineを使っています。バージョンは4.26となります。Creative TechnologyのPlater Performerみたいなサーバーは使っていませんが、必要な機能はほぼすべてまかなえています。

ハードウェアは、ハイセンス社製のパネルを上2枚と下2枚に組んで、そこに表示するためのPC1、PC2があります。ほかにはコントロール用PCと制作用PCなど、多数のPCを使用しています。

――PCが1台あればバーチャルプロダクションは実現できると思ったのですが、これだけの台数が必要なのですね。1台のPCから複数モニターへ映像出力できるのかと思っていました。

岡田氏:

確かに自由に設定はできますが、実験室は受注案件の環境再現が目的なので、ここではPC1台で2台のモニター、合計2台で動かしています。他の大手スタジオでも、だいたいPCは4台使っていますね。数十枚、数百枚で構成したLEDウォール全体をどのように切り出すのかで、それぞれ担当PCがある感じです。

あと、キーになるのがカメラトラッカーです。実験環境ではトラッキングシステムプロバイダーのAntilatencyを試していましたが、今日はVIVEトラッカーを使っています。Unreal Engine側から見ると、RedSpyやStARTrackerと同じ扱いで、ここでテストした結果をRedSpyに読み込むことも可能です。

――ちなみにAntilatencyとは、どのようなものでしょうか?

岡田氏:

Antilatencyはロシアのベンチャー企業の製品です。情報は少ないですが、一部のXR界隈で話題の製品で試しに導入してみました。

RedSpyやStARTrackerは反射マーカーシールを天井や床に多数貼って、そのマーカーシールとの関係値で自分の位置を決めています。一方、Antilatencyは床の光をとらえて自分の位置を決めます。原点は常に真ん中と決まっているのは面白いと思いました。

ただし、Antilatencyは技適未取得機器で、私達は総務省の「技適未取得機器を用いた実験等の特例制度」を申請して実験を行っています。そのため、別の場所では使用できません。

――実験室のPCの仕様やコストも気になります。どのようなPCを導入されているのでしょうか?

岡田氏:

PCにはNVIDIAのRTX A6000のグラフィックスカードが入っています。恐らく今稼働している大手スタジオもこちらを採用しているのではないでしょうか。このグラフィックスカードは非常に高価で、約60万円です。マシン全体では1台あたり約200万円で、それが3台稼働しています。

――実験環境を実現するうえで、もっとも苦労したところを教えてください

岡田氏:

ここではUnreal Engineの4.26バージョンで動作していますが、実際の現場によってはバージョンがバラバラで、ある現場は4.26で、別の現場では4.25の場合があります。現場によってバージョンが変わると、さまざまな常識がすべて覆されることがあります。また、Unreal Engineのバージョンアップのペースが早くて、ついて行くのも大変困難です。

次世代Unreal Engineにはバーチャルプロダクションの機能が盛りだくさん

――Unreal Engineのロードマップが発表されました。岡田さんが気になる機能を教えてください

岡田氏:

次世代ロードマップで気になるのは「Live Link FreeD」です。FreeDは、主にバーチャルスタジオシステムにおいてカメラのトラッキング情報伝達用に広く採用されているプロトコルです。RedSpyやMo-SysStarTracker、PTZカメラ対応のFreeDが、今後直接Unreal Engineで受けられるようになります。これまではこれらのカメラに対応しておらず、Realityやdisguise、Touch Designerで1回受けてUnreal Engineに渡して行っていたのですが、今後は直接できるようになります。

岡田氏:

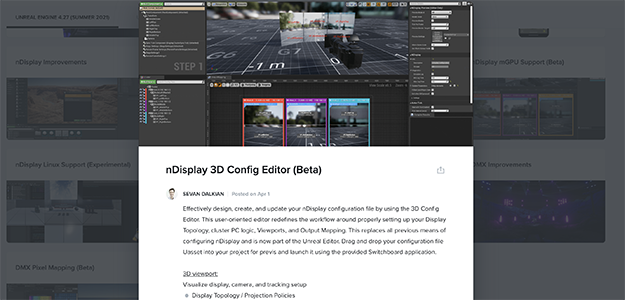

nDisplay 3D Config Editorは、複数の同期されたディスプレイデバイスでUnrealEngineシーンをレンダリングするための機能です。従来は、目見当で開発する必要がありましたが、今後はようやく見た目をプレビューしながら作業可能になります。

岡田氏:

次にLens Distortion Workflowsです。これもRealityやdisguiseが行っていた部分をUnreal Engine側ができるようになります。

岡田氏:

DMX Improvementsは照明制御の機能です。従来もできたんですけど、とりあえず機能がついていたような状態でした。今後、機能的に強化して画像から照明に変える機能が搭載されます。

岡田氏:

こうしてみるとUnreal Engineはアドビのクリエイティブツールと一緒で、プラグインで実現していた機能が公式機能として取り込まれる感じです。しかも、Realityやdisguiseが持っていた機能が本家に取り込まれるアップデートを予定しています。ただ楽しみではあるのですが、これすべて使える人もいるのか疑問も感じます。

――Unreal Engineは、これだけの機能を無料で使えるという認識で間違いないでしょうか?それとも有料オプションとかあるのでしょうか?

岡田氏:

無料という言い方をすると無料です。ここで紹介した機能もすべて無料で使用可能です。

Unreal Engineは、作成したゲームの売上が100万ドル以上を超えると5%のロイヤリティが発生する、というビジネスモデルです。100万ドルとは日本円で約1億円から1億1000万円以上です。売上が100万ドル未満の場合は費用は発生しません。

また別の話として、映像制作やイベント利用など、最終アウトプットがゲーム(プログラム)では無い場合は、ほとんどの場合無料で使用できます。これはシステム自体を販売しているわけではないためです。

ただし、Unreal Engineには有料プレミアムサポートに私達は加入しています。それでもそのサポートフィーの金額はほかのソリューションに比べたらかなり割安な金額ですね。

――Unreal Engineがあればソフトウェアの面ではバーチャルプロダクションをカバーできますが、ではなぜ大型案件や大手スタジオではZero Densityやdisguiseが選ばれているのでしょうか?

岡田氏:

Zero DensityのReality、disguise、Smodeなどは映像演出やイベントの業務に特化したソリューションとして作られています。その対応範囲の中にバーチャルプロダクションが入っており、各ソリューションの使い方がわかれば利用可能です。実は今挙げたReality、disguise、Smodeの3つは、Unreal Engineベースで稼働しており、それらができることはUnreal Engineでもほぼ可能なのも事実です。

先ほども説明した通り、Unreal Engineはゲームエンジンに代表されるソフトウェアであり、必ずしもバーチャルプロダクションやイベント業務に特化したものではありません。ですので、現場利用の意味でいうと、各社のソリューションを使った方が業務上、都合がいい場合が多いです。例えばイベント、音楽ライブ、ある程度フォーマットのある業務として考えると、なにかしらのソリューションを使った方がやりやすいですし、スタッフの教育がしやすい面もあります。

繰り返しになりますが、Unreal Engineはなんでもできますが、大変プリミティブ(原始的)な環境と言えます。やらなければいけないことが多いのも事実です。必ずしも業務向けとは言えません。

――最後にバーチャルプロダクションの現場を通して、期待や可能性についてコメントがあれば聞かせてください。

岡田氏:

Unreal Engineのプラットフォームを導入によって、映像業界ゲーム業界、映画もイベントな人たちが、同じ共通言語でしゃべるようになるのは大きいと思います。実際、disguiseやReality、Smode、VizrtBrainstormも、すべてUnreal Engineベースですから、共通言語のUnreal Engineはこれから大変に重要なると思っています。Unreal Engineをベースに、業界全体を盛り上げていければと思っております。