txt:荒木泰晴 構成:編集部

はじめに

「天災は、忘れたころにやってくる」の例え通り、3Dも同じです。

最近は「アバター」以後、数年がブームでしたね。現在のハリウッド作品は、「3D版」があるのが普通になりました。でも、アバターのように、3Dに観客が殺到する状態ではありません。

当たり前になったのか、観客が飽きたのか、定かではありませんが、2Dの映画を3D化する場合、「3Dとして構成されていなければ不自然なシーンも強引に立体化してしまう」ことや「3Dとして認識できないような短いカットもそのまま3D化する」ことが起きているようです。

爺は「ゼロ・グラビティ」をあえて2D版で見ましたが、短いカットの連続や、動きの激しいシーンが多く、「3Dで見たら耐えられない」と思ったことを覚えています。

日本では、「アバター」の大ヒットに慌てて、「ステレオグラファー」のタイトルを付けて短期間で3D技術者を養成しましたが、ブームが終わると仕事がなくなり、他の部署を担当するようになってしまいました。

現在、日本の大型3D映像制作はほとんど停滞して、「経験者がいない」事態になっています。

2025年の大阪万博には、「超巨大デジタル3D映像パビリオン」の出展が予想されています。直前になって「大型3Dをどう作っていいかわからない」となると、結局「適当にお茶を濁す」結果になるでしょう。

このレポートでは、「0から3Dをやってみたい」、という方々に、押さえてもらいたいポイントを解説して行きますが、「文章を読むことが苦手では、理解できません」と始めに申し上げておきます。

3Dの実写を動画で撮影する場合

CGやアニメーションで3Dを制作する場合、3D効果は計算で作ることができ、時間が許せば、個人作業なら時間や予算を無視しても納得できるまでやり直すことができます。

実写の風景や劇映画は、「撮影してみたがどうもうまくいかないので、もう一度」ということは、封切りの期限や予算の制限でできません。確実に撮影するためには、事前に使用機材でテスト撮影をして、上映される大きさで不自然な3Dになっていないかを検証する必要があります。この手順を無視すると、ロクな結果になりません。

3Dブームが短期間で終わってしまう原因は、「原理、原則を理解していないスタッフが、短時間、低予算で、粗製乱造する」ことに尽きる、と爺は思います。

何しろ、「比較される作品はアバター」ですから、これ以下の作品に観客が同じ金は払わないのは自明の理ですね。爺の経験では、日本では唯一、博覧会の予算を掛けた3D映像が観客の納得できる質を確保していたようです。 「次回の3Dブームが短時間で終わらない」ことを願って、「爺のいやがらせ」を書きましょう。

2台のカメラで実写を撮影する

ここでは、CGやアニメ、2Dを3Dに変換するのではなく、左右2台のカメラで劇映画やドキュメンタリーなどの実写を撮影する場合について書きます。

肉眼に優る3Dシステムはありません。2台のカメラで3Dを撮影する場合、肉眼の3D性能にいかに近付けるかを、まず検証しなければ始まりません。

■肉眼の場合

アナタは、自分の眼で見ている状態を考えてみたことがありますか? 人間の眼は、何故二つあるのでしょう。

3Dの解説本には、「人間は左右の眼の視差を利用して立体映像を見ている」と書いてあります。

それを、もっと具体的に書くと、

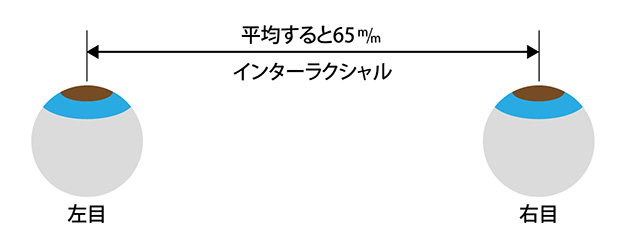

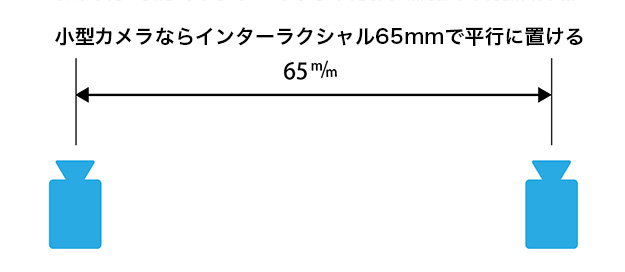

(1)左右の眼の中心の間隔(インターラクシャル)は平均して65mm

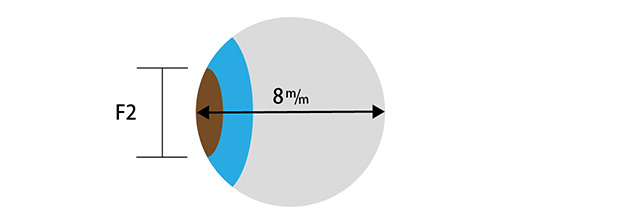

(2)眼球の焦点距離は約8mm

(3)明るさは約F2

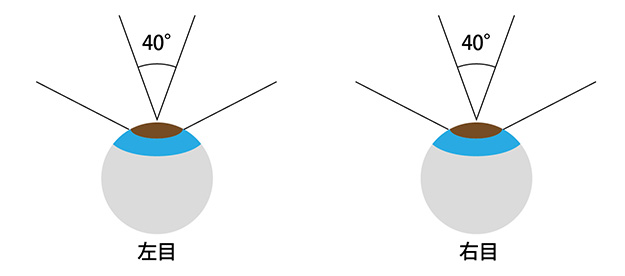

(4)左右の水平画角は約40°。ボーっと見ている範囲はほとんど180°をカバーしていますが、注目して見ている範囲は40°程度です。

■3Dカメラの場合

肉眼の性能をカメラに置き換えてみましょう。

人間の眼は、「8mm F2のレンズ付きで、画角40°をカバーするカメラが2個付いている」と置き換えられます。GoProにちょっと長めのレンズを付けたようなものですね。

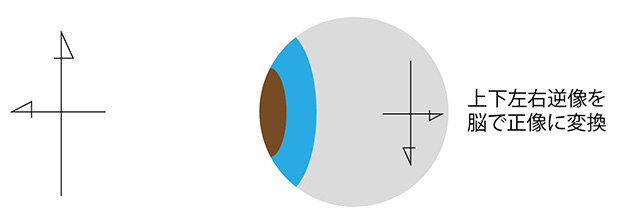

そして、オートフォーカス、自動適正露出、自動感度調整、上下左右逆像自動正像変換、自動瞬時立体視の機能を持っています。レンズ交換はできません。

3Dデジタルカメラでできないのは「自動瞬時立体視」です。他の機能はDSLRでも実現できていますし、レンズ交換は自由です。

肉眼と3Dカメラの誤解

左右両眼で、3mあたりから先の風景を見ている場合には、眼球は「平行の状態」で見ています。肉眼にとって一番楽な状態です。

3mから手前の近い物体を見る場合、自動的に「寄り目」になって行きます。

アナタの人差し指を、徐々に近づけて見ると、寄り目になって行くのがわかりますね。

20cm以内に近付けると、立体視の限界を超えて、肉眼でも指が2本に見えてしまいます。この状態では非常に疲れます。これを「立体視の破綻」と言い、3Dカメラでも同じことが起きます。

平行に見ている眼球の距離を「インターラクシャル」、寄り目になった状態を「コンバージェンス」と言う、と解説本に載っています。

この理由から、3Dカメラでは「インターラクシャルとコンバージェンスを併用する」と、どの本にも書いてあります。これは「全くの誤解か、ウソ」で、爺に言わせると「実際に3Dを制作したことがない著者が書いた」のがバレバレです。

「経験がない」のは、例えば3Dカメラマンでも、「撮影から小画面のラッシュ試写までで、実際の上映会場で映写の状態まで見ていない」ことも含まれます。自分の撮影した作品を、上映会場で見て、「アレっ、イメージと違う!!と、思ったときには、もう遅い」ってことです。

爺もペェペェの頃は同じ体験をしました。プロデューサーになって、納品する時に上映館で立ち会いながら見て、その結果をフィードバックしながら、質を高めて行ったもんです。

閑話休題。

「水平画角40°=フルサイズで50mm程度」のレンズを装着した2台のカメラのレンズの中心を65mmの間隔で「平行」に置けば、肉眼とほとんど同じ条件になり、3m以遠を撮影する場合には、自然な立体感が得られます。

一方、3m以内の近距離を撮影する場合、2台のカメラを「交差する配置にして、コンバージェンスを調整しろ」と、解説本に書かれています。

もう一度しつこく書きますが、「ここが肉眼とカメラの決定的な誤解」です。

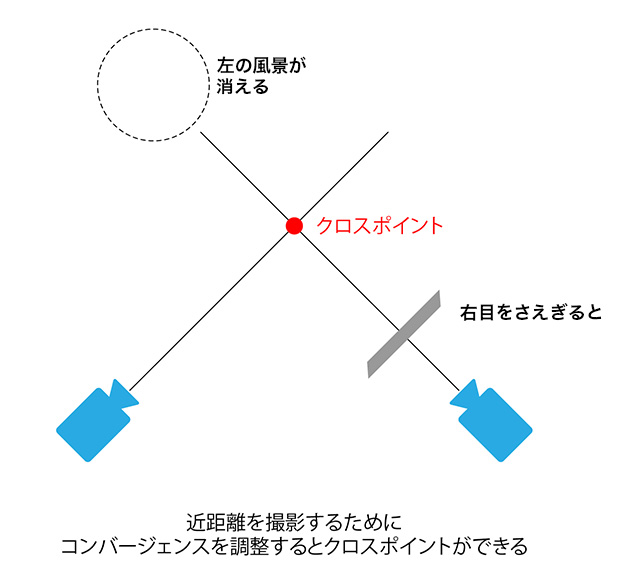

肉眼にはクロスポイントがない

左右2台の3Dカメラで、1m以内を撮影するためにインターラクシャル65mmのまま、コンバージェンスを調整すると、画面の中心が交差する「クロスポイント」ができます。クロスポイントから先の被写体は、右カメラには左の被写体が撮影され、左カメラには右の被写体が撮影されます。

そこで、右のカメラのレンズを遮ると、左の風景が消えます。

「何を当たり前のこと言うんだ」とアナタは思うでしょう。

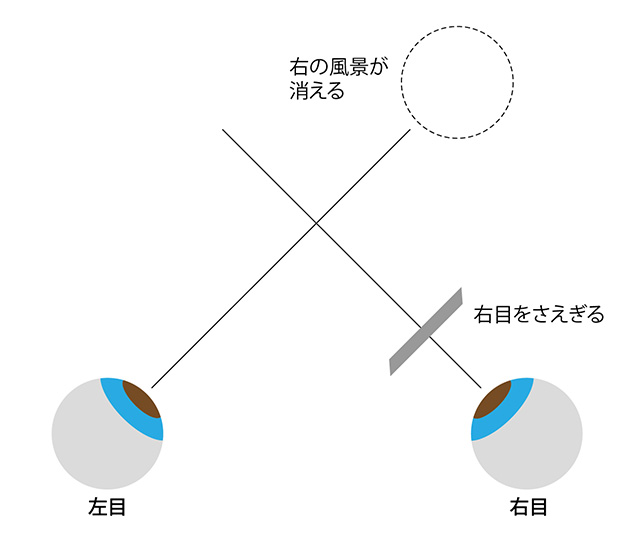

ところが、肉眼では違います。

アナタの指を顔の前、20cmほどに置いて、指にピントを合わせると、肉眼でも遠い風景は二つに見えています。そこで、右目を隠してください。右の風景が消えます。左目を隠すと左の風景が消えます。

肉眼では、コンバージェンスを調整しているようでも、クロスポイントはありません。

ここが脳の素晴らしい能力で、視界の外から獣などが襲ってくる場合、左右が入れ違っては、逃げる方向が判断できないからだと考えられます。

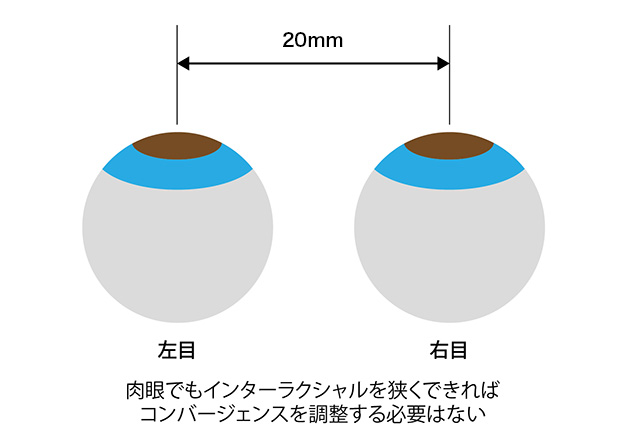

逆に考えれば、肉眼のインターラクシャルを65mmより狭く調整できれば、寄り眼にする必要はないわけです。

残念ながら、人間の眼の間隔は決まっていますから「万、やむを得ず寄り眼にして、近距離を見ざるを得ない」のです。

ここまでで、肉眼と3Dカメラの違いがご理解いただけたでしょうか?

3Dカメラでどうする

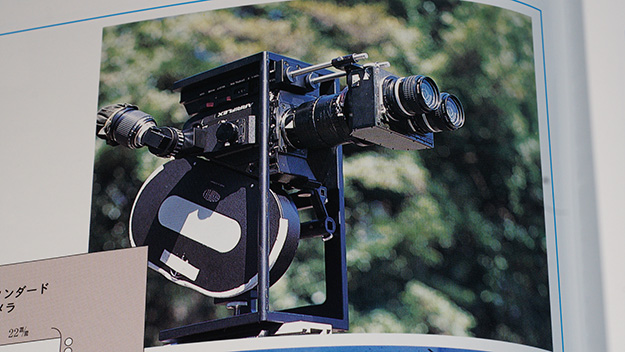

2台のカメラのレンズの中心を65mmに置くには、小型のカメラを平行リグに乗せれば、意外に簡単に3Dカメラを作れますが、大型カメラで8K高精細3D映像を撮影するためには、平行リグではインターラクシャル65mmには置けません。

2台の大型カメラのレンズ中心間隔を65mmにするには、

(1)レンズを平行にシフトする方法

(2)ハーフミラーを45°に組み込んで直角にカメラを配置する方法があります。

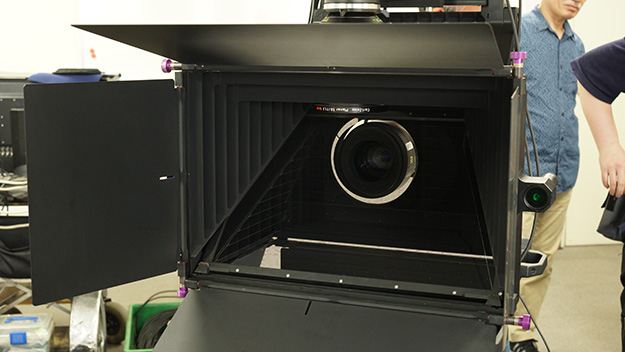

ソフィアプレシジョン社製、超精密ハーフミラー3Dリグ。レーザー光で、インターラクシャル、コンバージェンス、カメラの傾きを精密にセッティングできる

45°にセットされた50%のハーフミラー

直角に2台セットされたソニーF55

ハーフミラーリグの場合、インターラクシャルを0にできますから、リグの縁、ギリギリまでのクローズアップ撮影が3Dで可能です。

インターラクシャルの調整

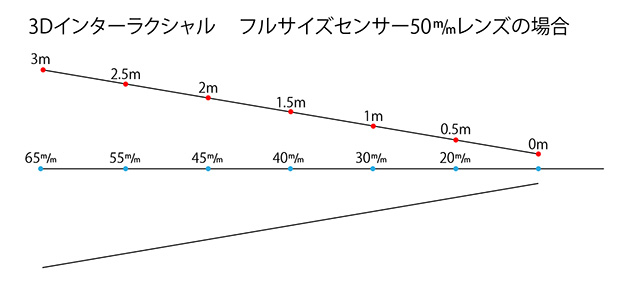

撮影距離、無限遠から3m程度までは、インターラクシャル65mmで差し支えありませんが、3m以内に近付く場合、徐々にインターラクシャルを狭める必要があります。

表にすると、こんな感じです。

ただし、これはフルサイズで50mm、水平画角40°程度の場合です。ワイドレンズに交換すると、インターラクシャルをもっと狭める必要があり、望遠レンズではもっと広げる必要があります。これは、上映画面の大きさによって調整する必要があり、経験で判断するしかありませんでした。

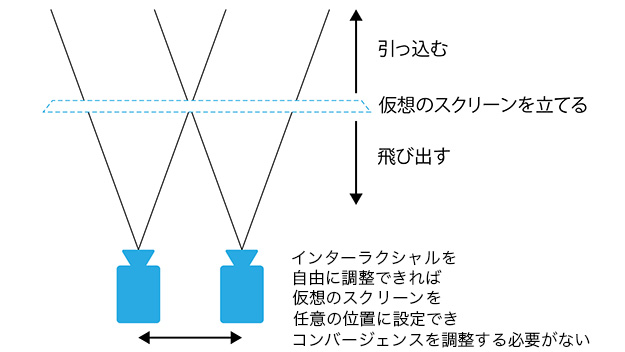

仮想のスクリーンを立てる

爺は、インターラクシャルを合わせる地点に、三脚など基準になる棒状の物を置き、2台のカメラの上下左右をシフトして重ね合わせます。ここがインターラクシャル0mmで、ここより手前にあるものは飛び出して見え、遠いものは引っ込んで見えます。

これを「仮想のスクリーンを立てる」と、言います。

こうすると、ワイドレンズから望遠レンズまで同じ操作で調整ができます。

基準になる棒などが立てられない場合は、スクリーンから飛び出させたい被写体の後にインターラクシャルの0ポイントを決め、仮想のスクリーンを設定します。

目印になる場所であれば、机の角や建物の窓など、どこでも構いません。

コンバージェンスを調整するとどうなる

3m以内の近い被写体を撮影する場合、インターラクシャル65mm以上のまま、左右のカメラを内側に振り、コンバージェンスを調整すると、仮想のスクリーン面から手前にある「飛び出させたい被写体」が徐々に仮想のスクリーン面方向へ引っ込んでいきます。

これは、インターラクシャルを狭めたと同じ効果です。

インターラクシャルを35cmで8K3Dを撮影した例がありますが、強引にコンバージェンスを調整しても、近距離のインターラクシャルは35cmのままで、奥の風景もクロスポイントができて左右が入れ違ってしまい、相乗効果で非常に疲れる画面になります。このようなカットを連続して繋いでいくと、賢明なアナタはもうおわかりでしょう。

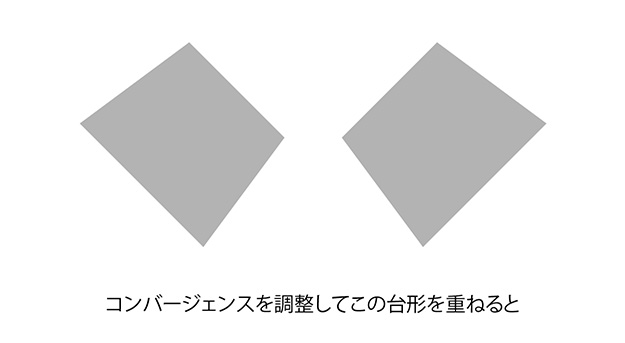

コンバージェンスを調整すると、更に困ったことが起きます。

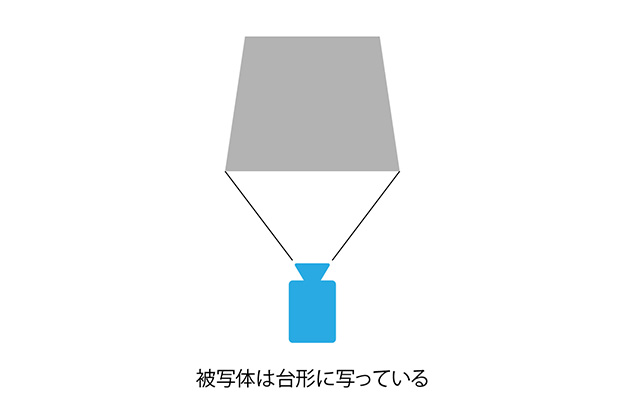

レンズには、パースペクティブがあるため、手前の被写体は大きく写り、奥の被写体は小さく写る「キーストン(図形)歪み」が避けられません。

つまり、被写体は台形の立体に写っているわけです。この現象はワイドレンズほど顕著です。この画面をコンバージェンス調整すると、非常に複雑な形に重なります。

この画面にCGなどを合成しようとすると、膨大な手間と時間がかかります。結局、キーストン歪みを補正してから合成することになり、何のためにコンバージェンスを調整したのかわからなくなります。

爺の経験では、「インターラクシャルだけを調整するのが正解」です。

実際の3Dカメラ

■フジビジョン(FUJI VISION)3D

フジビジョン3D、レンズ側はニコンマウント。ボディ側は各種マウントに交換できる

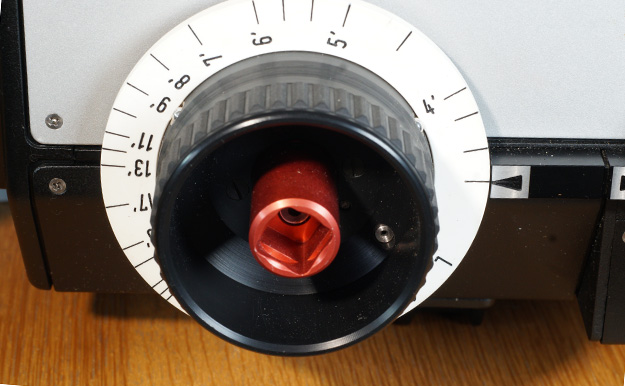

フジビジョン3Dは、向かって左レンズ側には上下のシフト、右側には左右のシフト機能を持っています。最短のインターラクシャルは約70mmです。コンバージェンス調整機能はありません。

フジビジョン3Dは向かって右のダイヤルで左右シフト、左上のダイヤルで上下シフトを調整する。撮影画面はシネマスコープ同等の縦横比

70mmギリギリにインターラクシャルを狭めるために、左右のレンズに段差が付いています。

2本のニッコールAIレンズをセット。段差が付いている

ここがフジビジョンの最大の欠点で、1mほどの近距離から飛び出してくる刀や槍が2本に見えてしまいました。近距離の撮影にも限界があります。

日本シネセルのカタログより。カメラはアリフレックス35Ⅲ。光学系を簡素化するため、カメラは転倒している

■3Dアリビジョン(ARRIVISION)

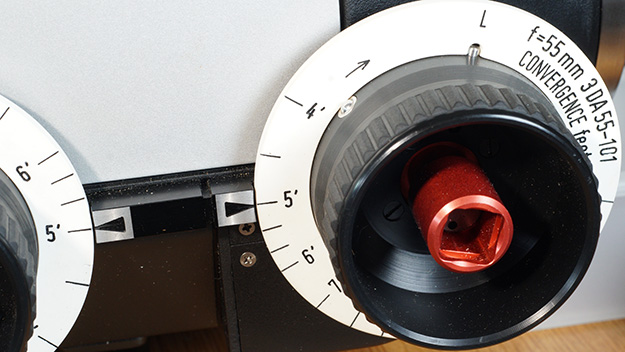

3Dアリビジョン55mm。この他に40mm、28mm、28mmに18mmワイドコンバーターを取り付けて、4種の焦点距離で撮影できる。PLマウント

3Dアリビジョンは、小型レンズを新規に設計してインターラクシャルを正確に65mmにしてあります。

55mm無限遠、インターラクシャルは65mmに固定

そのまま、クロスポイントができない範囲で、コンバージェンスだけを調整します。

4フィートの状態。寄り目になっている

左右のレンズに段差はありませんから、飛び出してくる被写体も不自然になりませんが、近距離の撮影にはフジビジョン3Dと同じように限界があります。

最短撮影距離は3フィート強だが、実用的には4フィートまで

撮影距離と同じ位置にコンバージェンスを調整するだけ

フジビジョンとアリビジョンは日光江戸村の「忍者3D」を撮影したシステムですが、芝居を撮影している分には、3D効果に不満、不都合はありませんでした。

「ジョーズ3 3D」も3Dアリビジョンで撮影されましたが、調整が簡単な方が望ましいのは当然のことです。

1988年に日光江戸村で公開された「大坂城炎上」のパンフレットより

撮影中の村野カメラマン。カメラはミッチェルMK II

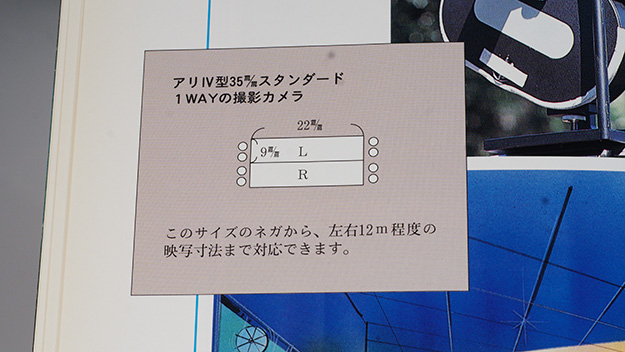

この2機種は、35mmスタンダードフィルム4パーフォレーションのカメラを使い、2パーフォーレーションずつ上下に撮影するシステムです。2台のカメラで撮影する場合に起きるコマずれはありません。

撮影ネガのイメージ。アリフレックスIV型はIII型の間違い

爺はビスタビジョン(フルサイズ相当)の大型フィルムカメラ2台の平行リグを作りましたが、電気的なシンクロではなく、段付きベルトで2台を繋いで、絶対にコマずれが起きないように作った経験があります。

■J(爺)VISION 3D

爺は、できるだけシンプルに4K3Dを撮影したいと考え、ソニーα6300、ニコンEシフトアダプター、ニッコールAIフルサイズ用レンズを左右2セット組み合わせて、「フジビジョン3D」を2台に分けたようなシステムを作ってみました。

α6300はAPS-Cセンサーのカメラですから、フルサイズ用のニッコールAIを用いると、360°自由にシフトできますし、爺手持ちの18mmから105mm程度のレンズは交換自由です。

ソニーα6300、ニコンEシフトアダプター、ニッコールAI35mm F2レンズ

組み上げた状態、シフトせず

向かって左へシフト

アダプターは自由に回転でき、上下シフトもできる

三光映機製平行リグ

左右2台をセット。インターラクシャルを最短約70mmにするために、向かって右のカメラは上下逆にセット。70mm以内のインターラクシャルはシフトで調整する

シフトアダプターによって、フジビジョンやアリビジョンより近距離までインターラクシャル調整ができます。GENロック機能はありませんから、長時間のカット撮影には向きませんが、2台を回しておいて、カチンコを撮影すれば、1分程度のカットではコマずれしません。

4Kなら、幅20mのスクリーンに良い画質で上映できることは確認済みです。

3D撮影の注意点

■レンズ交換する場合

3D映像でも、フルサイズセンサーカメラを使い、50mmだけで撮影できれば、インターラクシャル調整もシンプルで、肉眼に近い映像が得られますが、シナリオの要求によって、レンズを交換しなければならないこともあります。

レンズ交換をした場合、ワイドレンズで撮影した広い風景から、急激にクローズアップに繋ぐと、観客の3D調整能力が追い付きません。長めのオーバーラップを使うか、中間サイズの画面を1カット挿入して、緩やかに3Dとして認識できるようにします。

極端に肉眼の条件を逸脱した例では、1km程彼方(ほとんど無限遠)にあるスタートゲートから飛び出してくる競走馬を、ゲートを仮想のスクリーンにして、1200mmレンズで3D撮影した経験がありますが、インターラクシャルは約450mmでした。

こんな撮影は、肉眼ではあり得ません。

■「巨人の眼」現象

さて、インターラクシャルを65mm以上に広げ、例えば100mmにすると、「両眼の幅100mmの巨人が見ている」ように、被写体が小さく写ります。

これを「GIANT‘S EYE=巨人の眼」現象と言います。

「博多山笠の曳山」をビルの窓から撮影した時に、インターラクシャルを広げて、道路と曳山の立体感を強調したことがありましたが、巨人の眼現象を、あえて無視する場合もあります。

■「キツネ顔」現象

また、ワイドレンズを被写体に近づけると、顔が細長く写る「キツネ顔現象」が起こります。

ある作品で、ビスタビジョンフィルムカメラ(フルサイズ相当)2台の平行リグで、ニッコールPC28mmシフトレンズを使い、中国の「兵馬俑」を撮影したシーンで、兵士の顔がキツネの顔のように、変形して見えてしまった経験があります。カメラを兵士から離して、50mmで撮影すれば防げたのですが、後ろは土の壁になっていてカメラ位置が自由にならず、条件を逸脱した結果です。

3Dに向かない、3Dにならない場合

無限遠の被写体は肉眼でも3Dに見えていません。自然の風景を撮影する場合、遠景、中間、近景をバランスよく配置する画面構成が必要で、劇映画では出演者の配置にも気を配る必要があります。

平面上にある細かいパターンの被写体は凹凸があっても、3Dとして認識できません。例えば「風に揺れる小さな花々の群落」「浅い川の流れ」を真上から撮影するような画面です。

ボケ過ぎた背景の手前にある被写体は3Dになりません。パンフォーカスが基本です。アリビジョン3Dでは強制的にパンフォーカスにするために、レンズの開放T値は6.8です。

3Dアリビジョンの開放T値は、6.8で統一されている

被写体がファインダーフレームをはみ出すと3Dに見えなくなります。

老若男女の差によって、3Dとして画像を認識する時間が違います。

短いカットを連続して編集すると、立体視が混乱して目眩が起こる世代がいることを考慮に入れてください。若い世代向きのアクション3Dと、老若男女どの世代にもアピールすることが必要な博覧会映像では、3Dとして認識できるカットの長さが違います。

特に監督がこれらの特性を理解しないと、観客を無視した「独りよがりの3D」ができてしまい、アッという間にブームが去ります。

万能の3Dカメラはない

自然な3D映像を目指して、世界で様々なカメラや撮影方法が試されてきました。肉眼が楽に見ている条件では、どんな3Dカメラでも顕著な差がないことはご理解いただけたでしょう。

対して、極端なクローズアップなど、特殊な条件では、インターラクシャルが確実に0にできるハーフミラーリグが必要です。

(1)インターラクシャルだけを調整する、小型軽量な3Dカメラ

(2)大型で重くはなるが、クローズアップを撮影するハーフミラーリグ

を、撮影する条件に応じて、柔軟に使いこなす技術がなければ、観客が納得する目に優しい3D映像は撮影できない、というのが爺の結論です。

■3D編集と3D音響

撮影だけでは3Dとして観賞できるようにはなりません。編集にも3D向きのテクニック、「風景のロングショットから急にクローズアップへ繋がない、カット変わりにはオーバーラップを併用する、短いアクションカットでは、3Dとして認識できるまでインターラクシャルを変えていないカットを選んで繋ぐ」など、編集上の配慮が必要です。

音響にも気を配る必要があります。

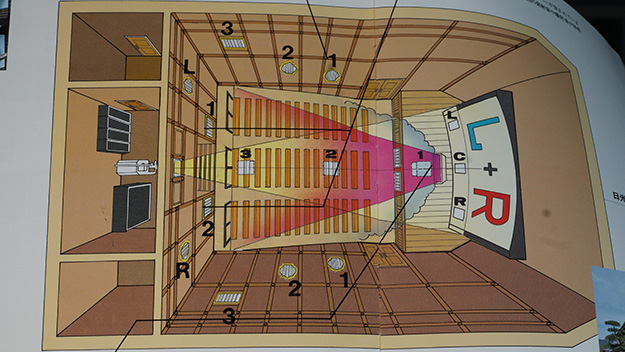

日光江戸村の「大坂城炎上」3D制作では、16チャンネルのスピーカーを図のように配置して、音響も超立体化したことがあります。画面だけでなく、音も大きな3D効果を産む要素です。これはVRでも応用できるでしょう。

日光江戸村3D劇場。スピーカー配置。客席はスクリーンの幅からはみ出していない

■ステレオグラファーとは

撮影だけが仕事だと思っているうちは、「ステレオグラファーなんぞと、名乗るのはおこがましい」。3Dに適する企画から上映の質まで責任を持って、初めて「ステレオグラファー」です。となると「ステレオプロデューサー」を、育てるべきでしょう。

■3D劇場の上映環境

一般の2D劇場を3D上映に転用する場合、ホワイトスクリーンをシルバースクリーンに貼り替えます。これは安価な偏光眼鏡を使った3D観賞に対応するためですが、スクリーンの幅を大きく超えた客席では、偏光角度を超えてしまい、3Dとして鑑賞できません。

また、シルバースクリーンで2Dを上映すると、反射率が大きいので、ギラギラした不自然な画面になってしまうことが、多くのカメラマンから指摘された歴史もありました。

■画面酔いや頭痛

人間の肉眼の能力を超えて強制的に3D画面を見せることは、画面酔いや頭痛を誘発します。アクションと穏やかなシーンを織り交ぜ、疲れた脳を休ませる配慮が必要不可欠です。

停滞期の今こそ

3Dに限りません。

ソフトを制作するスタッフの能力と劇場のハードが連携しなければ、観客に良質な映像を提供できません。日本の3Dを一時的なブームで終わらせず、定着させるためには、停滞期の今こそ、3D制作を目指すスタッフがじっくりと3Dの特徴、特性をテストして理解し、長い時間をかけて少しずつ3Dに慣れて行くことが何よりも大切です。

ま、「どうせ日本ではできないネ」と、爺は思っていますが。

ブームになってから、また0から始めますか?

WRITER PROFILE