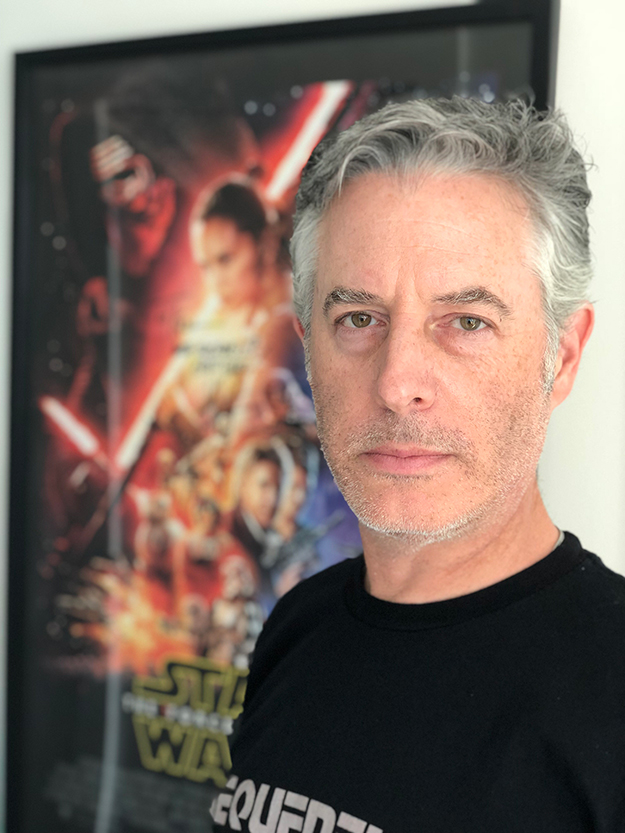

※画像と記事は直接関係ありません(イメージです)

txt:鍋潤太郎 構成:編集部

パイプラインTD/フリーランス Ken Ibrahim氏インタビュー

過去の本欄で、2015年9月「初心者向け:プロダクションにおけるパイプラインとは」、2016年4月「中級者向け:ハリウッドのVFXスタジオにおけるパイプラインとは」というコラムをお届けしたが、今回はその続編という形で「上級者向け」である。前回同様、ハリウッドのVFXスタジオで実際にパイプライン開発に携わっておられる専門家の方へのインタビューを行ってみた。

今回、お話を伺ったのは、こちらの方である。

ケン・イブラヒム-Ken Ibrahim

パイプラインTD/フリーランス1990年に文部省(当時)が主催するJETプログラムに合格し、群馬県太田市の中学校へ英語教師として1年間赴任。一度帰国した後に再来日し、セガ第3AM研究開発部にてキャリアをスタート、開発業務に携わる。セガに在籍中は「セガラリーチャンピオンシップ」等の著名ゲーム・タイトルの中で英語セリフの声優としても活躍。その後エイリアス・ウェーブフロント東京支社に移籍しセールス・サポート・エンジニアを担当、アメリカに転勤した後も同業務を継続した。その後、エフェクト・アーティスト&パイプラインTDとして数々のハリウッド映画に参加し、20年以上の経験を持つ。参加作品にはPDI/Dreamworksにおける「シュレック」(2001)を始めとする数々のハリウッド映画が含まれる。近年はJ・J・エイブラムス率いるBad Robot/Kelvin Opticalと契約し「スター・ウォーズ/フォースの覚醒」や「スター・トレック BEYOND」等の作品でパイプライン開発を担当した。現在は活動範囲をVFXのみならず、Unity3Dを使用したARや、産業ロボット用のMAYAプログラム開発、考古学サイトの為の遺跡データ・キャプチャなどに広げ、余暇にはVRや電子音楽の制作に余念がないという。

イブラヒム氏は、日本での生活経験もあり、日本語が大変ご堪能である。今回のインタビューは英語で行われたが、「パイプライン開発者の、現場でよく使用する言い回しや、テクニカル用語を、敢えて含めてください」というリクエストを添えて、お願いした。

その為、VFXアーティストの方には少々難解かもしれないが、その分、リアルな内容になったのではないかと思う。

ちなみに、筆者のバックグランドはVFXアーティストであるので、本欄をエンジニアや開発系の方がお読みになると、不自然や訳や、不詳な点、既知の情報、物足りない点などがおありかもしれないが、どうかご容赦頂ければと思う。また、下記はイブラヒム氏の経験に基づく見解が述べられているので、異なるご意見をお持ちの方もおられる事と思う。これらを前提に、今回のコラムは「実際にハリウッドでパイプライン開発に携わっておられる方の、現場の生の声」という観点でご参考頂ければ幸いである。

――数百人規模の、大規模なVFXスタジオにおいて、パイプラインに求められるものは?

開発者にとって、堅牢なパイプラインを構築する際の最も重要な点は、モジュール性、可読性、そしてメンテナンス性です。これは、パイプラインが一定規則に沿ってコーディングされ、きちんとしたドキュメンテーションが用意されることを意味しています。

PythonはVFX業界で最も一般的なスクリプティング言語ですから、コーディング規約PEP8とDRY原則を併用することが前提になります。つまり、すべての変数、関数、クラスに対して、的確なネーミング・コンベンションを定めるべきです。PythonのDocstringsは、Sphinx等を介して適切なフォーマットで作成されたドキュメントを使用するべきでしょう。事前に十分検討されたクラスとモジュールは、後々のメンテナンスや更新を容易にします。また、後で別のTDがコードベースで作業する必要がある場合などに、ストレス軽減にも繋がります。

――Pythonの話が出ましたが、パイプライン開発で、最も使用される開発言語は?

現在、VFX業界で最も普及している開発言語は、間違いなくPythonでしょう。これは、過去10年間で最も使用されている2Dと3DのDCC(Digital Content Creation)の中で、VFX業界の共通言語となっています。

但しMayaのツールにおけるメンテナンスでは、MEL等の従来のスクリプトシステムを使用する場合もあります。Mayaのプラグインの開発にはC++も使用されますが、コンパイルされた言語はある程度のオーバーヘッドが生じます。

Houdiniの場合Pythonも使用しますが、より処理速度を上げるため、多くのOPでVEX言語を使用することが推奨されています。

――GDC2018やSIGGRAPH2018などで、リアルタイムエンジンが脚光を浴びています。これらがVFX業界にもたらすものは?

現時点で、UnityやUnrealなどのリアルタイムエンジンが活用されている分野がいくつか存在しています。その最たるものはプレビズ分野でしょう。先見の明がある映画監督が既に採用している手法ですが、リアルタイムエンジンで開発されたツールを使用する事により、カメラの動きやショットをリアルタイムで見ることが出来ます。

SIGGRAPH2018にて

この方法によって、監督の頭の中にある構図やアイデアが、シネマティック・フローにリアルタイムにフィードバック可能です。これは、バーチャル・ストーリーボードとも言える手法です。このバーチャル・プロダクションがプリビズ分野で活用された作品には、映画「アバター」、「リアル・スティール」「ジャングル・ブック」等があります。

それ以外の分野では、プロダクション会社はリアルタイム・テクノロジーを実際のショットの最終レンダリングに採用し始めています。その一例を挙げますと、映画「ローグ・ワン/スター・ウォーズ・ストーリー」で、Unreal Engine 4がドロイドK-2SOのレンダリングに部分的に使用された事例や、ディズニー・テレビジョン・アニメーションがこの9月から放映を開始した「ベイマックス」の短編シリーズ「Baymax Dreams」でのUnityの使用事例などがあります。

リアルタイム・フォトリアリスティック・レンダリングは、ノンリニア・ワークフローに基づいて生産性を大幅に向上させ、UnityとUnrealは共に非常に魅力的なソリューションを提供しています。Unrealは高品質なレンダラーで首位を走り続けていますが、対するUnityは今年、ゲーム以外の業界を対象とした、更に進化したフォトリアリスティック・レンダリングを、スクリプティングが可能なレンダリングパイプラインという形でリリースしました。

私自身もUnityを使用した経験がありますが、タイムラインとシネマティックカメラサポートに長けていると感じました。

――Unityにおける「タイムライン」と「シネマティックカメラサポート」とは、どのようなものなのでしょうか?

リアルタイムエンジンは通常リアルタイムで実行されるため、タイムラインがありません。しかし、UE4とUnityの両方が、リニアのタイムラインでのアニメーションをサポートしています。

SIGGRAPH2018にて

シネマティックカメラサポートとは、タイムラインのフレーム範囲間のショットで、複数のバーチャル・ショット・カメラをベースに、実際に使用するカメラを制御します。Mayaにも、複数のショットカメラを定義出来る機能がありますが、それと似たような機能と考えれば解り易いかもしれません。

――ハリウッドの現場で作業をしていると、まだまだ2Kが主流で、しかもレンダリング時間も相当なものです。しかし、世の中は4Kや8Kに向かっています。どうしましょう(笑)。

VFXにおける高解像度の大きな影響はレンダリング時間の増大と、レンダリングされたファイル毎にメモリーのフットプリントが大きくなります。これは、ほとんどのVFXスタジオが抱える共通の問題であり、レンダリングプラットフォームをGoogle Cloud Platform、Amazon AWS、MS Azureなどのクラウドに切り替えていく可能性が高まっていると思います。

これらのクラウドプラットフォームの安全性は高くなってきており、プロセッサ使用率とストレージスペースの両方の即時スケーラビリティを提供します。彼らは現在、CPUに加えてGPUノードも提供しており、Chaos GroupのV-Ray NextやOTOYのOctaneRenderなど、より高速なスピードでより多くのレンダラを使用することができます。

――イブラヒムさんは、これまで様々なVFXスタジオでお仕事をされてこられました。これまでの経験から、最もパイプラインが優れていたのは、どのスタジオでしたか?

私の経験では、映画「ファイナルファンタジー」(2001)の制作で参加した、ハワイのスクウェア・ピクチャーズで開発されたVFXパイプラインが、最も使い易く、完成度が高かったと思います。このパイプラインの構造は、テクニカルな人にも現場のアーティストにも、ファイル・ストラクチャーや”パブリッシュ”された最新バージョンのアセット管理などが理にかなっており、大変バランスの良いパイプラインでした。

また、多くのVFXパイプラインと同様に、ディスク上のアセット管理における難解な構造やメカニズムから、可能な限りアーティストを開放して、彼らが作業に集中出来るよう構築されていました。

残念ながらスクウェア・ピクチャーズは閉鎖に至りましたが、数多くのアーティスト達や主要パイプライン・アーキテクト開発者がデジタル・ドメインに移籍した事もあって、このシステムのアイデアは、その後デジタル・ドメインに、ある意味で受け継がれ、良い影響を与えたのではないかと思います。

――VR・AR・MRが、VFX業界に与える恩恵は?

SIGGRAPH2018でもVRは人気

前述のように、VRはプレビズ分野で活用されています。また、VRは映画のリリースと時期と前後して、映画の世界観を体験出来るVR体験映像として、宣伝用にも使用されています。これらのVR体験映像は、本編のプロダクションで使用されたデジタル・アセットを使用したり、本編の未使用ショットなどが使用される事もあります。

私は現在、VR開発に取り組んでいますが、Unityを使ってARアプリケーションの開発を行っています。この開発をしていて思う事は、テクノロジー面とアート面の両方で、VFXの経験がとても役に立つワークフローだと思います。もちろんリアルタイムとプログラミングの経験は要求されますが、デジタルアセット作成の仕組みは殆ど同じで、ラーニング・カーブはあまり急勾配ではないと思います。

VFXと共通する部分も多く、今や私が知っている殆どのポストプロダクションハウスはVR部門を持っており、私がかつて作業を共にしたVFX現場の仲間達の多くがVR系に移行しています。

雇用促進の面でもメリットがあると思います。アメリカには、学費の高いVFX専攻の学校を、自分で学費ローンを組んで卒業した新卒の学生が大勢います。彼らにとって、VR・AR・MRの仕事は、VFXのアーティスト達に多くの新しい雇用オプションを提供していると思います。

――最近の制作現場で、新しい市販ツールや、話題になっているツールについて耳にされた事はありますか?

正直なところ、私は人気を得ている新しいDCCパッケージについては、あまり聞いたことがありません。しかし、業界標準DCCのすべてが常に向上しており、新しい機能を追加しています。例えばMayaやHoudiniのアップデートは、学習してマスターするための新機能とテクニックが満載で、すべてのレンダラーアップデートには新しいデフォルトのシェーダーが適応しているようです。

NVIDIAの新しいQuadro RTXレイトレーシングGPUは、VFXワークフローでパラダイムシフトを起こす可能性があるという興味深い新しいハードウェアアナウンスがあります。

もしかしたら皆さんもご存知かもしれませんが、EQUINOX-3Dという無料で強力な3Dモデリングとアニメーションパッケージをチェックすることに興味があるかもしれません。完全に統合されたインタラクティブなレイトレーサーを備えています。

――ハリウッドのVFX現場で人気のレンダラーは何でしょうか?また、それらはパイプライン開発面では、どのように映りますか?

クオリティとスピードの両面で見て、ハリウッドのVFX業界で最近人気が高いのはV-Rayなのではないかと思います。特にレイトレースにおける、モーションブラーの掛かった透過や反射部分などのクオリティが高いです。また、V-Ray GPUでGPUレンダリングも提供しています。

Arnoldは現在、ご存知のようにMayaにバンドルされており、Mayaユーザーが活用出来る強力で簡単なオプションです。

RenderManは新しいRISパストレーサを使って「復活」を遂げました。かつて私が契約していたBad Robot/Kelvin Opticalでも「スター・ウォーズ/フォースの覚醒」や「スター・トレック BEYOND」の両作品で使用していました。ノイズ除去を行うdenoiserは、レンダリング時間を劇的に短縮することを可能にしました。

HoudiniのレンダラーであるMantraは、これまで多くの作品のエフェクト素材のレンダリングに使用され、常に改良され続けており、プロダクションに適したレンダラーと言えます。

さて、大規模VFXスタジオにおいて、異なるデパートメント(部門)間で、異なるレンダラーを使用する際の共通の課題として、カットアウトとモーション・ブラーのミス・アライメントがあります。これは「修正」するのが非常に難しい場合があります。そのような問題を回避するには、VFXスタジオ内では単一のレンダラに統合して、コンポジット部門の為に一貫した画像を出すのが最適ではないかと私は考えています。例えば、カオスグループ(Chaos Group)は、V-Ray for Houdiniをベータ版で提供し、さらにV-Ray for Nukeをサポートしています。

――SIGGRAPHでメイキングセッションを聴講していると、クラウドレンダリングを使用した話も耳にするようになりましたね。

クラウドベースのレンダリングサービスは、セキュリティとインターネット環境の問題を解決することによって、より魅力的になってきています。他の技術と同様に、クラウドレンダリングソリューションは時間と共に大幅に改善されましたが、クラウドレンダリングへ移行する際の最大の課題はセキュリティでした。

たとえば、Google Cloud Platformは、ディズニーや、多くのプロダクション会社など、セキュリティに厳しい会社が利用しています。ご存知のようにディズニーは、さまざまなハイプロファイルIPのために非常に高いセキュリティを求めてくる事で知られています。という事は、ディズニーにとって十分安全であれば、誰にとっても安全だということです。

クラウドコンピューティングのメリットは数多くあり、VFXの世界では、高速なスケーラビリティとレンダリングの”馬力”に繋がります。CPUとGPUレンダリングの両方の為に、特定のソフトウェアとハードウェアプロファイルを持つクラウドマシンを構成することは、比較的簡単です。

たとえば、特定の基準に基づいて、Houdiniからの流体シミュレーションのレンダリングファームを迅速に作成し、CLIでいくつかのコマンドを使用してV-Rayでレンダリングすることが出来ます。ArnoldまたはRenderManを使用して、マルチレイヤーの画像のレンダリング用に別のプールを簡単にセットアップすることも出来ます。これらはテンプレートのコンフィグレーションによって設定可能です。このようなシステムの利点は、ショー(プロジェクト)やスタジオのニーズに応じて、簡単に拡大または縮小することが出来る点です。

今日の典型的なポストプロダクションの施設では、ある程度の規模のマシンルームを構築し、可動に必要な電力の確保と、熱の考慮事項を含めて維持されますが、レンダリングが走っていない休止時間は遊休ノード=コスト損失という事になります。これらの懸念事項は、クラウドコンピューティングで解決されます。ショーが終了すると、クラウドノードは単に解放されます。

また、クラウド・レンダリングは従量課金なので、クラウド使用レポートを介して追跡出来ます。これは、ディリー試写でVFXスーパーバイザーによる無計画な変更要求が何度も発生し、無駄なレンダリングを繰り返すと、制作費をドンドン浪費するという事実が把握出来る為、結果としてワークフロー上の無駄に対する抑止効果に繋がります。

――ハリウッドのVFXパイプラインはLinuxが主流ですが、小規模スタジオや日本のVFXスタジオではWindowsを採用している会社も少なくないと思います。LinuxとWindowsでパイプライン開発に違いはありますか?

パイプライン開発の基本はどちらも同じです。Pythonはクロスプラットフォームでコンパイルされていないため、大部分のコードは同じように動作します。

LinuxではPythonディストリビューションが通常既にインストールされています。OS Xも同様です。Windowsの場合は、コードが実行される前に、Python実行可能ファイルをWindowsマシンにインストールする必要があります。

2つのOSの最大の違いの1つは、パス区切り文字とそれをエスケープする必要があることです。Linuxではスラッシュ(”/”)が使用され、Windowsではバックスラッシュ(”\”)が使用されます。いくつかのPythonモジュールはこれを考慮に入れていますが、パスを自分で構築するときは注意が必要です。

そのような些細な違いが、時にはスタジオ全体を巻き込む大きな問題に発展することあります。また、スクリプトをサブプロセスとして実行するなど、いくつかのOSレベルの細かい違いがあります。

――パイプラインは、今度どのように変革&発展していくと思われますか?

私は、今後のデジタル・アーティストは、自宅からリモートで仕事をするスタイルに徐々に移行していくのではないかと考えています。セキュリティの問題さえ解消されれば、「遠隔チーム」を持つことでオフィススペース等の施設インフラストラクチャと、関連するメンテナンス費用の必要性が無くなります。

これはコンピュータのインフラストラクチャばかりではなく、例えば従業員用のキッチン、コーヒー、自動販売機、トイレ等も含まれます。これは、メジャー・スタジオにとっては無限のコスト削減策に役立ち、よりスリム化が可能となるビジネスモデルです。

これは、上記のクラウドレンダリング・ソリューションのように、主要なDCCやPhotoshopなど、必要なソフトウェアが全てインストールされたクラウドベースのワークステーションを迅速にセットアップすることが出来ます。アーティストは自宅にモニター、キーボード等の周辺機器と一緒に、ストリームを受信する為の小さなボックスを用意するだけです。このバーチャル・ワークステーションは、VFXスタジオ側から容易に維持管理出来、アクセス権限は必要に応じてコントロールする事が出来ます。これらを念頭に置いて開発を進めると、パイプラインはそれに従って発展し、よりモジュラ化され、分散されたシステム全体で機能するようになるでしょう。

VFXスタジオが自社ソフトウェアを開発する代わりにサードパーティのDCCやレンダラを採用するように、サードパーティのパイプラインソリューションが普及すると思います。 その一例を挙げますとShotgun Toolkitがあります。これにより、アーティストは、統合されたソリューションのためにDCC内からShotgunプロダクションデータベースと直接対話できます。これらのパッケージは、Pipeline TDがショー(プロジェクト)の特定の要件に対応するAPIを提供します。しかし、現在のスタジオ・パイプラインとは異なり、パイプラインはプロジェクトごとに再構築する必要がないように、開発が最小限に抑えられる可能性が高いでしょう。

――今日は、どうもありがとうございました。

おまけ:リモートワーク

以上、イブラヒム氏から大変興味深いお話を伺ってみたが、何かとご参考になる点も多かったのではないだろうか。

余談であるが、最後の項で言及されていた「自宅からリモートで仕事をするスタイルに徐々に移行していく」という点については、筆者も実際にハリウッドのVFX制作現場で目にしつつある。最近では、人材募集の投稿に「リモート可」というフリーランサー案件もチラホラ目にするようになった。

大手VFXスタジオやアニメーションスタジオでは、「週に〇〇時間まで」のような形でリモートワークを認めている会社もある。その場合、自宅のPCに専用ツールをインストールする事で、勤務先の自分のマシンにログインする事が出来る。すると自宅PCのモニターには、勤務先のマシンの画面がそのまま表示される。

筆者がオフィスで残業している時、隣のアーティストが家からログインして作業を行うと、誰も居ないデスクのモニター上で、カーソルと画面だけが黙々と動いているという、まるで幽霊が仕事をしているかのような不思議な光景を楽しむ事が出来る(笑)たまにマシンがハングしてしまい、その人から電話が掛かってきて、「ごめん、ちょっとマシンをリブートしてくれる?」などと頼まれる事があるのもご愛敬である。

こうして現場で見ていると、リモートワークは、締め切り前の忙しい時期にひどい風邪を引き、オフィスで他のアーティスト達に伝染させてしまうのを防いだり、小さなお子様を抱えるママさんアーティストが家から仕事が出来るなど、何かと利点も多いようだ。「今朝、バスルームの修理が来るので、午前中だけ家から仕事します」そんなメールが回ってくる事もある。今後リモートワークは、ハリウッドのVFX制作の現場では、増えていく事だろう。

このリモートワークについては、またいつか、折をみてレポートしてみたいと考えている。

WRITER PROFILE