取材:鍋 潤太郎 構成:編集部

はじめに

ここ数年、GPUの高速化やゲームエンジンの台頭によってリアルタイム・レンダリングが注目を浴びているが、これに加えてリアルタイムエフェクトの分野でも様々な進化が目覚ましいと聞く。そう言われてみれば、米VESアワードの受賞カテゴリの中にも「Real-Time」関連部門が追加されて久しいが、筆者のように映画のVFX、言ってみれば「プリレンダーのエフェクト制作」に慣れ親しんだ立場からすると、“リアルタイムエフェクト”はまだまだ未知の領域でもある。

そこで今回は、この分野の専門家である池田 亘氏に、米ゲーム業界におけるリアルタイムエフェクトの最新動向について、詳しくお話を伺ってみた。

池田 亘(いけだ わたる)Naughty Dog – Visual Effects Artist

福井県出身。1999年に大阪芸術大学デザイン学科を卒業後、株式会社スクウェア・エニックス(旧株式会社スクウェア)に入社し、「Final Fantasy XI」などに背景アーティストとして携わる。その後リアルタイムVFXに転向し、株式会社カプコンに入社後は「Lost Planet 2」のリードFXデザイナーを経てVFXテクニカルアーティストとしてエフェクトエディタ開発を行う。その後、EA DICE(スウェーデン)に移籍し、「Battlefield 1」や「Star Wars Battlefront II」の開発にVFXアーティストとして参加し、現在はNaughty Dog(アメリカ)に所属し、「The Last of Us Part II」に携わっている。

16年以上リアルタイムエフェクトの分野に従事し、CEDEC 2015、CEDEC 2018、UNREAL FEST EAST 2018での登壇や、専門学校・大学などでの講演および特別講義なども行っている。

――リアルタイムエフェクトとは、どのようなものでしょうか?

リアルタイムエフェクトとは、ビデオゲームやVJ(ビデオジョッキー)など、入力やインタラクションに対して即座に適切な視覚効果が発生するもので、基本的に画面の更新頻度に合わせて毎秒30回~120回といった描画を連続して行うものを指します。

最もポピュラーなリアルタイムエフェクトは、パーティクル(頂点の情報に対してアニメーションを付与したもの)です。そのパーティクルの位置に対してポリゴンメッシュや、ビルボードもしくはスプライトと呼ばれるカメラに正対した板を表示することで、皆さんがビデオゲームで目にしている銃のマズルフラッシュ、着弾時の火花や煙、爆発といった動的なものを表現しています。

他にも滝、水しぶき、山火事、溶岩、砂埃、枚落ちる木の葉といった自然現象に紐づく動的な表現や雷、吹雪などを含む多くの魔法も含まれます。更に、ユーザーインターフェースに用いられる複雑な挙動の一部も、このリアルタイムエフェクトが担うことが多々あります。

リアルタイムエフェクトは、画面の賑やかしとしてだけではなく、ゲームやリアルタイムコンテンツの中で「何が起こっているか」、という反応をユーザーもしくは視聴者に伝えるために非常に重要なものです。

SIGGRAPH2019におけるUnreal Engine 4の「Chaos」デモ

――リアルタイムエフェクトの歴史は、意外に長いそうですね。

ビデオゲームでは、ドット絵の2Dのころから火の玉や爆発、剣の残像といったエフェクトは存在していましたので、それも含むと、リアルタイムエフェクトの歴史の古くは1950年代から、60年ほどになるのではないでしょうか。

私が把握している範囲では、DEC社PDP-1のコンピュータの「Spacewar!」というゲームの中で、弾に当たった時に負けた表現として、ドットの粒子が飛び散るものがあります。簡易的な表現ではありますが、立派なリアルタイムエフェクトと言えます。

3Dの世界では、商用としては1980年にATARIで発売された「Battlezone」というゲームの中で、敵の戦車を破壊した際や火山にパーティクルが使われています。リアルタイムエフェクトの重要性は、「どのゲームから始まった」という訳ではなく、徐々に高まっていったのではないでしょうか。

ハードウェアの発展に伴い、キャラクターや背景と同様に進化をしてきましたが、近年はアーティストがシェーダーを扱うことが増えてから、より多彩な表現が増え、作品に合ったテイストのエフェクトが作られるようになっていった、という経緯があります。

以前は、日本のゲームの方が比較的複雑かつ丁寧な作りのエフェクトが多かった印象を受けましたが、最近ではそういったアドバンテージは少なくなったように感じます。しかし、日本のアニメやゲームに使われているエフェクトが世界に与えてきた影響は大変強く、それは米国や世界で見られるリアルタイムエフェクトに反映されていると断言出来ます。

――プリレンダリングのエフェクトと、リアルタイムとでは、どのような違いがありますか?

リアルタイムエフェクトは先述のとおり毎秒30回以上の描画を行いますので、エフェクトの品質や複雑度は使用するハードウェアの性能に大きく左右される、という点が大きな違いのひとつではないでしょうか。

リアルタイムエフェクトは、性能に見合わない複雑な描画を行うと、「処理落ち」と呼ばれる規定以上に画面のフレームレートが低下する状態に陥るため、画面が滑らかに動かない、コマ落ちしているように見えるといった、快適なゲームプレイの妨げになる現象が起こります。毎秒60回で描画されるFPS(1人称視点のシューティング)ゲームや格闘ゲームでは、レベルの高いプレイヤーにとってはこの処理落ちによるタイミングの欠損によって勝敗を左右しかねません。

また、VRコンテンツにおいては最低でも毎秒60回、理想的には120回以上の描画が要求されます。VRコンテンツにおける処理落ちは、ユーザーの「酔い」に直結しますので、必ず避けなければならないものです。

このため、リアルタイムエフェクトに携わるアーティストやプログラマは、この処理負荷を低く保ちつつ画面のクオリティを維持する事に、かなりの時間を費やします。例えば、水の動きや見た目が物理計算にそぐわなかったとしても、結果の計算量が少なく、かつ実物に近い表現であれば、それは「大成功」といった具合です。

一方、プリレンダリングでは、事前に全て計算して映像にしています。つまり毎秒〇〇回の計算を意識する必要がありませんので、時間の許す限り、複雑で細かいディテールを盛り込んだエフェクトを作成することが出来ます。ただし、リテイクや修正の際に1フレームに何十分もかかるシミュレーションを再び行わなければならない可能性も秘めていますので、どちらも一長一短で、リアルタイムエフェクトと比較して「どちらが良い」という訳ではありません。

昨今はGPUの飛躍的な性能の向上により、プリレンダリングや映画には届かずとも似たクオリティのエフェクトを、リアルタイムで表現することも可能になってきました。CPUを使った計算よりも、高速に処理を行うことが出来るGPUに処理を肩代わりしてもらうことが出来るため、高速なGPUを搭載したコンソール機やPCでは、百万以上のパーティクルを実際のコンテンツで扱うことも可能となってきています。

また、少し前から使われ始めた技術として、VAT(Vertex Animation Texture)と呼ばれる、ポリゴンメッシュの頂点アニメーションを事前にテクスチャに焼き付けておき、その情報をもとにゲーム中に頂点の位置情報を再現し、複雑な形状変化を表現する技術が脚光を浴びています。

――リアルタイムエフェクトの制作には、どのようなDCCツールが利用されるのでしょうか?

エフェクトに適用するテクスチャやポリゴンメッシュは、Houdini、Maya、3ds Maxなどの一般的なDCCツールを使用することが多いです。液体表現のテクスチャもしくはポリゴンメッシュを作るためにRealflowといった流体シミュレーションに特化したツールを使うこともありますし、炎や煙、爆発などのためにFumeFXのようなプラグインを使うことも多々あります。テクスチャの作成においてはPhotoshopやAfterEffectsも併用するのが一般的です。

最近では、テクスチャを作成する際にSubstance Designerを使用するケースも増えました。無限に近いバリエーションを生成することが出来ますので、一度仕組みを作ってしまえば、あとから発生する細やかな修正に迅速に対応できるだけでなく、別のタイトルでも同じようなテクスチャを1から作る必要がないのが大きな長所です。

リアルタイムエフェクト自体の見た目とアニメーションの構築、つまり「エミッター」と呼ばれるパーティクルの発生源を複数組み合わせて1つのエフェクトを作り上げる作業では、「ゲームエンジン」と呼ばれるゲーム開発の統合環境に含まれているエフェクトエディタを使うのが主流と言えます。

例えば、爆発のエフェクトを作ろうと思った場合は、煙、爆炎、衝撃波、飛び散る火花や破片、余韻となる地面の煙、地面の焦げ付きといったエミッターを用意し、それぞれに違ったアニメーションのパラメータやテクスチャを適用して、何度も画面上で爆発エフェクトを発生させながら調整を重ねて完成させていきます。

比較的大きなゲームスタジオは、自社の独自のゲームエンジンを開発し、自分達に適したツール作りや機能の搭載を行って、開発効率の向上と独自の表現を目指しています。ゲームエンジンの自社開発が出来ない環境であったとしても、ここ数年はUnreal EngineやUnity3Dといったゲームエンジンを使ってゲーム開発ならびにリアルタイムエフェクトの習得や作成を行うことが出来ますので、大変良い時代になったと感じます。

SIGGRAPH2019におけるUnityブース(筆者撮影)

――リアルタイムエフェクトの長所&短所はありますか?

長所は、何と言っても「リアルタイム」で描画が行われることです。エフェクトアーティストは思い描いたエフェクトを形にするために試行錯誤しますが、シミュレーションやレンダリングの時間を待つことなく、パラメータの調整などの変更が即座に画面に反映されますので、プリレンダリングと比べてイテレーションに優れています。その為、リアルタイムエフェクトアーティストは1日に何百回もエフェクト発生のショートカットキーを押すことにはなるのですが…。

また、リアルタイムであることでインタラクションが実現します。エフェクトの発生タイミングや場所が不確定なもの、例えばシューティングゲームで「敵のどの部位を攻撃するか」はゲームプレイヤーに委ねられていますが、どの部分を攻撃しても、その場所から適切なエフェクトを発生させることが出来ます。

もしプリレンダリングで似たようなことをしたい場合、想定される全てのパターンのリアクション結果をシミュレーション並びにレンダリングして、さらにそれを莫大なデータ容量として確保しておかなければならないのではないでしょうか。

短所と言えるのは、ハードウェアの制限に縛られることです。頻繁に槍玉に上がるのは、半透明のエフェクトの描画負荷と、描画の際に起こる半透明の前後優先問題です。リアルタイムエフェクトにおいて半透明の描画処理は奥行き計算が正確に考慮されないため、半透明の描画順番で苦労することが多々あります。この問題の抜本的な解決策はいまだ確立されていません。

また、ハードウェアの性能の制限により、映画で見られるような街単位での超大規模な大洪水、複雑に動く炎の流体シミュレーションといった、計算に大変な時間が掛かるものを表現するには、「如何にそれっぽく見えるように、かつ軽い処理負荷にするか?」という点に注力しなければなりません。

ハードウェアの制限と同じではありますが、メモリの制限による妥協も常に付きまといます。ただし、その制限内で人々を驚かせるエフェクトを作ることに喜びを感じているリアルタイムエフェクトアーティストは、少なくないはずです。

SIGGRAPH2019におけるUnreal Engineブース(筆者撮影)

――米ゲーム業界における、リアルタイムエフェクトのトレンドは?

現在、比較的盛んにエフェクトアーティスト達が取り組んでいるのは、フォトリアル系のエフェクトよりも、ノンフォトリアル、スタイライズド、アニメ調のものになります。カリフォルニアにはBlizzard EntertainmentやRiot Gamesといった有名な会社がありますが、そういった会社が作っているスタイライズドエフェクトは大変人気です。

それを作ることが出来る=そのまま就職にも直結しますので。皆、とても研究熱心で、ひと昔前は日本が圧倒的なクオリティを誇っていたアニメ調のエフェクトも、米国だけでなく、中国などの世界中のエフェクトアーティストが次々とレベルの高いものを制作している状況です。

今年はリアルタイムレイトレースによる描画の進化のニュースが多かったのですが、エフェクトもこのリアルタイムレイトレースの恩恵を受けることになります。これまではスクリーンスペースリフレクションが主流でしたが、これは画面内に映っているものに限ってリフレクション(反射)の計算がされるものでした。

今後は、リアルタイムレイトレースによって画面の外にいる炎や爆発のエフェクトが金属などに反射して目に入る、といった状況が生まれます。より周囲の状況が把握できるようになりますので、ゲーム内でのプレイにも影響が出てくることが予想されます。

近い将来には次世代のゲーム機がこのリアルタイムレイトレースに対応して発売されるとの情報もありますので、すでに開発現場ではエフェクトのレイトレース対応をしているスタジオもあるのではないでしょうか。

米国に限定されるものではありませんが、リアルタイムエフェクトのツールはUnreal Engine4のNiagara EditorやUnity3DのVisual Effect Graphの登場で、これまで以上に複雑かつ面白いエフェクトの表現をアーティストのみで作り上げることが可能になっています。今まではどうしてもプログラマーさんの手助けが必要な個所が多かったのですが、特にNiagara Editorでは自分で好きにモジュール(機能のパーツ)を作ってエフェクトに反映させることが出来ます。

逆に言うと、このようなエディタを使いこなすために、「これまで以上に技術的な知識を要求される時代になってきた」とも捉えることが出来ます。リアルタイムエフェクトのアーティストにとって、シェーダーや簡単なプログラム知識は必須となってきているように見えます。

――リアルタイムエフェクトの今後は、どのように進展していくと思われますか。

今後、プロシージャルでの制作効率化はリアルタイムエフェクトでも更に進んでいくはずです。最近は素材制作でのプロシージャル、量産が盛んに行われるようになってきましたが、今後のハードウェアの発展でリアルタイム処理でのプロシージャルエフェクトの生成が出来るようになると、「さっきも同じ形、同じテクスチャのパターンのエフェクトを見た」といった不自然な絵は増々減っていくでしょうし、適切な場所に適切なエフェクトを自動(半自動)で発生させることが出来るものは増えていき、余計な手作業はどんどんと減っていくのではないでしょうか。もちろん、これまで通りにアートのコントロールをする余地を残した自動化です。

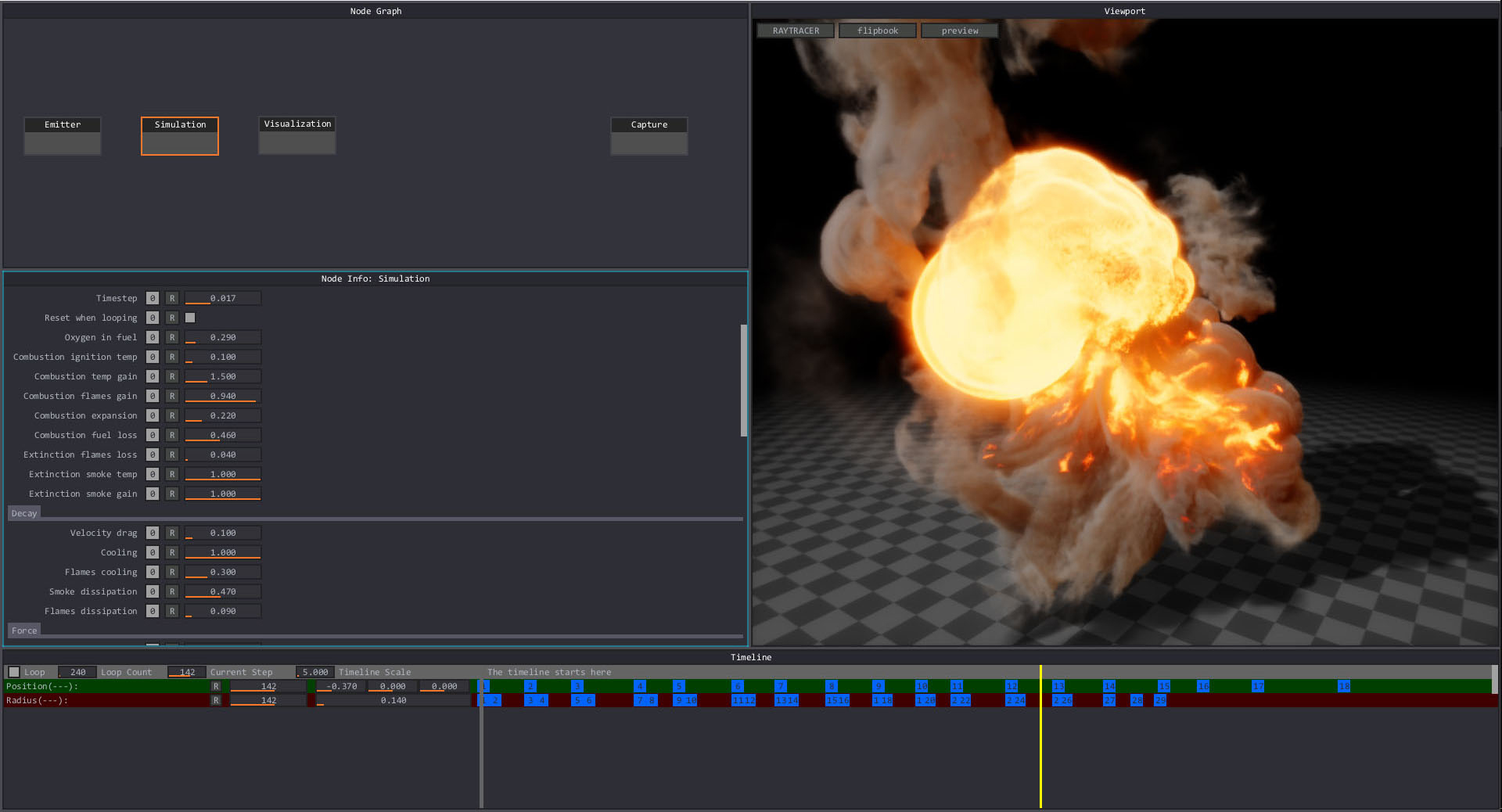

また、リアルタイム流体シミュレーションが本格的に利用される時期が近づいています。最近、EmberGenというリアルタイムで炎や爆発のシミュレーション、描画を行うことが出来るツールが登場し、注目を集めています。

EmberGenによるリアルタイムの流体シミュレーションのUI画面(池田氏提供)

EmberGenによるリアルタイムの流体シミュレーションのUI画面(池田氏提供)※画面はアルファ版のもので、今後変更される可能性があります

※画像をクリックすると拡大します

現段階では、このツールの目的は短時間で高品質な流体のテクスチャを作成することにありますが、今後こういったものが実際にそのままゲームやリアルタイム映像のコンテンツの中でシミュレーション、描画されることになっていくと思われます。

すでに日本ではSPARK社のSPARKGEARというミドルウェアがあり、リアルタイムの流体シミュレーションをUnreal Engine 4やUnity3D上で動かすことが出来ます。リアルタイムエフェクトアーティストの方は、来たるべき時に備えて、出来る事ならば今からこういったツール、ミドルウェアに触れて、リアルタイムでの制限内での流体制御に慣れておくのが良いのではないでしょうか。

今後、更に映画との表現力の差は減っていくとは思いますが、ハードウェアの制限がある以上は全く同等という訳にはいきませんので、今後もリアルタイムエフェクトならではの負荷軽減の工夫と努力は継続していくはずです。

――リアルタイムエフェクトに関する書籍を出版されるご予定だそうですが。

はい、リアルタイムエフェクトアーティストの中級者前後から上級者の入り口向けという位置づけで、「HoudiniとUE4で学ぶリアルタイムVFX(レベルアップのための心得と実践)」というタイトルです。発売日は2020年1月31日の予定です(出版元は株式会社ボーンデジタルさん)。

エフェクトの入門書は数多くありますが、中級者前後以降のレベルに向けた、しかもリアルタイムエフェクトに特化した内容の書籍というものは殆どないと思いますので、リアルタイムエフェクトの経験者の方で一歩先へ進みたい方に是非とも読んで頂きたい内容です。エフェクト制作者だけでなく、エフェクトに関わるテクニカルアーティストの方にも「発想の種」として読んで楽しんで頂きたい内容も含まれています。

私がこれまで16年以上に渡りリアルタイムエフェクトに携わった経験に基づいた、リアルタイムエフェクトアーティストに必要な素養や学び方、思考訓練となるエフェクトのチュートリアル(Unreal Engine 4とHoudiniを使用)やシェーダーのTIPS、プロシージャルエフェクトに関するものなどなど、幅広く内容を取り扱っています。

ご興味をお持ちの方は、是非ご一読頂ければと思います。

※発言は個人の見解であり所属する組織の公式見解ではありません

――今日は、どうもありがとうございました。

WRITER PROFILE